Deep Learning Notes

Introduction to Generative AI - Coursera

Generative AI can input only one modality and output multiple modalities.

DL can process more complex patterns than traditional ML.

\(y = f(x)\) | \(x\) is input data, \(y\) is model output and \(f\) is model.

Pre-Training: 1) Large amount of data; 2) Billions of parameters; 3) Unsupervised Learning

Transformer Challenges: 1) The model is not trained on enough data; 2) is trained on noisy or dirty data; 3) is not given enough context; 4) is not given enough constraints.

Prompt is given to the LLMs as input and it can be used to control the output of the model. (The quality of the input determines the quality of the output)

Hung-yi Lee 2021 Spring ML

1. Introduction

对一个模型的修改往往基于对问题的理解,也就是 domain knowledge

ML Framework (3 Steps)

-

Function with Unknown: \(y = b + wx_1\), \(w\) and \(b\) are unknown parameters (weight and bias), \(x_1\) is feature. \(\leftarrow\) Linear Model

-

Define Loss Function from Training Data: is a function of parameters \(L(b, w)\), \(L = \frac{1}{N} \sum_{n}^{}e_n\) and is from training data.

MAE (Mean Absolute Error): \(e = \vert y - \hat{y} \vert\)

MSE (Mean Square Error): \(e = (y - \hat{y})^2\)

-

Optimization: \(w^*, b^* = \arg \min\limits_{w, b} L\)

Gradient Descent: \(w^1 \leftarrow w^0 - \eta\frac{\partial L}{\partial w}\vert_{w = w^0,\ b = b^0}\), \(w^0\) is randomly picked and \(\eta\) is learning rate (a hyperparameter that dictates the speed at which the model adjusts its parameters during training). If gradient is negative (gradient guides the direction), increase \(w\) can decrease loss.

Step into DL

-

Function with Unknown

sigmoid: \(\frac{1}{1 + e^{-x}}\), \(y = c \ \frac{1}{1 + e^{-(b + wx_1)}} = c \ \text{sigmoid}(b + wx_1)\) 通过改变 \(w\)、\(b\) 和 \(c\)(constant),就可以得到各种不同形状的 sigmoid 函数。\(w\) changes slopes, \(b\) changes shifts and \(c\) changes heights.

利用 sigmoid 函数来替代阶跃函数作为非线性函数,可以组合各种不同的 linear model,得到 piecewise linear model,从而可以近似各种不同的 continuous function (non-Linear Model),即

\[y = b + \sum\limits_i c_i \ \text{sigmoid}(b_i + w_i x_1)\]如果对于不同的 feature 有不同的权重 \(w\),那么公式就会变成

\[y = b + \sum\limits_i c_i \ \text{sigmoid}(b_i + \sum\limits_j{w_{ij} x_j})\]\(i\): no. of sigmoid, \(j\): no. of features

用线代的形式可以表示为(Timestamp - 17:23)

\[y = b + \boldsymbol{c^T} \sigma(\boldsymbol{b} + \boldsymbol{WX})\]\(c\) 为 transpose 的原因是:矩阵乘法要求前一个矩阵的列数是后一个矩阵的行数。

Using \(\boldsymbol{\theta}\) to represent the unknown parameters \(\boldsymbol{W}, \boldsymbol{b}, \boldsymbol{c^T}, b\), so the function with unknown can be written as \(f_{\boldsymbol{\theta}}\).

-

Define Loss Function from Training Data

Loss \(L(\boldsymbol{\theta})\) is a function of parameters \(\boldsymbol{\theta}\),将训练数据经过 \(f_{\boldsymbol{\theta}}\) 得到的输出与 ground truth 比较计算出距离(例如 cross-entropy),将每个样本的距离加起来就作为 loss function \(L(\boldsymbol{\theta}) = \sum^N_{n=1}e_n\)。

-

Optimization: 对于 \(\boldsymbol{\theta} = \begin{bmatrix}\theta_1\\\theta_2\\\theta_3\\\vdots\end{bmatrix}\),要找到 \(\boldsymbol{\theta^*} = \arg \min\limits_{\boldsymbol{\theta}} L\),最终 \(f_{\boldsymbol{\theta^*}}\) 就是我们想要的那个 function。对于随机选择的初始值 \(\boldsymbol{\theta}^0\),计算出 gradient \(\boldsymbol{g} = \nabla{L(\boldsymbol{\theta}^0)}\) 后用 gradient descent 就可以更新所有的参数,即 \(\boldsymbol{\theta}^1 \leftarrow \boldsymbol{\theta}^0 - \eta\boldsymbol{g}\),通常不会有所有的训练数据去一次又一次地更新参数,而是将训练数据划分成多个 batch,用每一个 batch 去做每一次的 update(called it iteration),比如第一个 batch 得到一个 loss \(L^1\),用这个 loss 计算得到的梯度去更新 \(\boldsymbol{\theta}^0\) 得到 \(\boldsymbol{\theta}^1\),再用第二个 batch 更新得到 \(\boldsymbol{\theta}^2\),以此类推,把所有 batch 都看过一遍后叫做一个 epoch。

Rectified Linear Unit (ReLU): \(c\max(0, b + wx_1)\)

如果使用 ReLU 代替 sigmoid,需要两个 ReLU 才可以得到一个 hard sigmoid,则

\[y = b + \sum\limits_{2i} c_i \max(0, b_i + \sum\limits_j{w_{ij} x_j})\]这里的 sigmoid 和 ReLU 在 ML 中被称之为 Activation function

Neuron and Neural Network == hidden layer and Deep Learning

Overfitting: Better on training data, worse on unseen data.

2. DL

Backpropagation

神经网络通常有多层且每层有大量的 neuron,因此它会有上百万个参数,用 Backpropagation 就可以有效地计算这些参数的 gradient

-

Forward Pass: \(z = x_1w_1 + x_2w_2 + b \rightarrow \frac{\partial{z}}{\partial{w}}\)

-

Backward Pass: Function \(C\) determines the distance between \(\hat{y}\) (prediction value) and \(y\) (ground truth). \(\frac{\partial{\hat{y}}}{\partial{z}}\frac{\partial{C}}{\partial{\hat{y}}} \rightarrow \frac{\partial{C}}{\partial{z}}\)

-

Then, we will get the gradient of parameter \(w\) with respect to Function \(C\). \(\frac{\partial{z}}{\partial{w}} \times \frac{\partial{C}}{\partial{z}} \rightarrow \frac{\partial{C}}{\partial{w}}\)

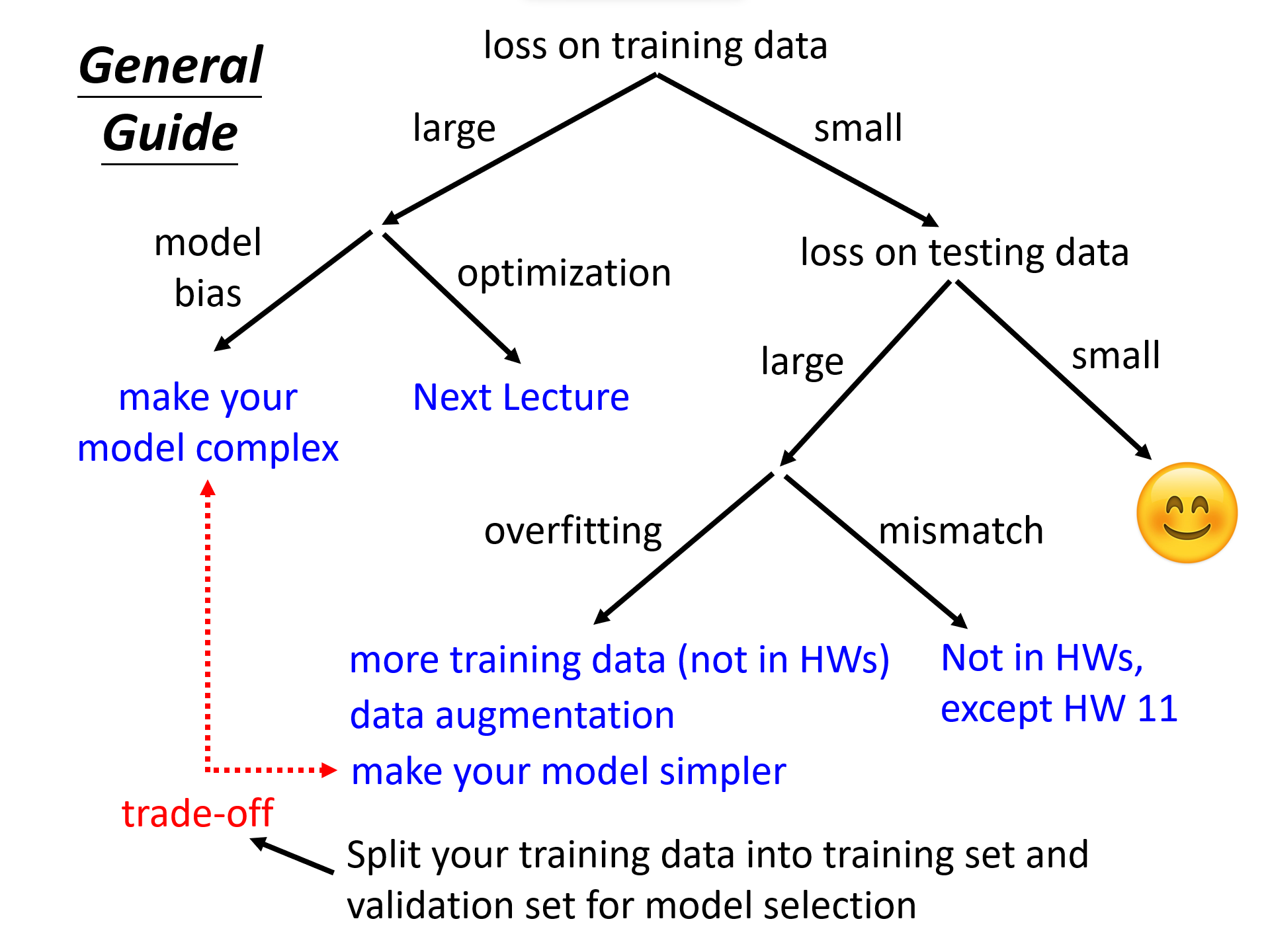

General Guide

Training: \(y = f_{\boldsymbol{\theta}}(\boldsymbol{x}), \ L(\boldsymbol{\theta}), \ \boldsymbol{\theta}^* = \arg \min\limits_{\boldsymbol{\theta}} L\)

Testing: \(y = f_{\boldsymbol{\theta}^*}(\boldsymbol{x}')\)

The loss on the training data is important and must be recorded. Before checking the test results, ensure that the loss on the training data is sufficiently small.

-

Training loss is large

-

Model Bias: model is too simple

Solution: Redesign the model to make it more flexible (more features, more complex architecture)

-

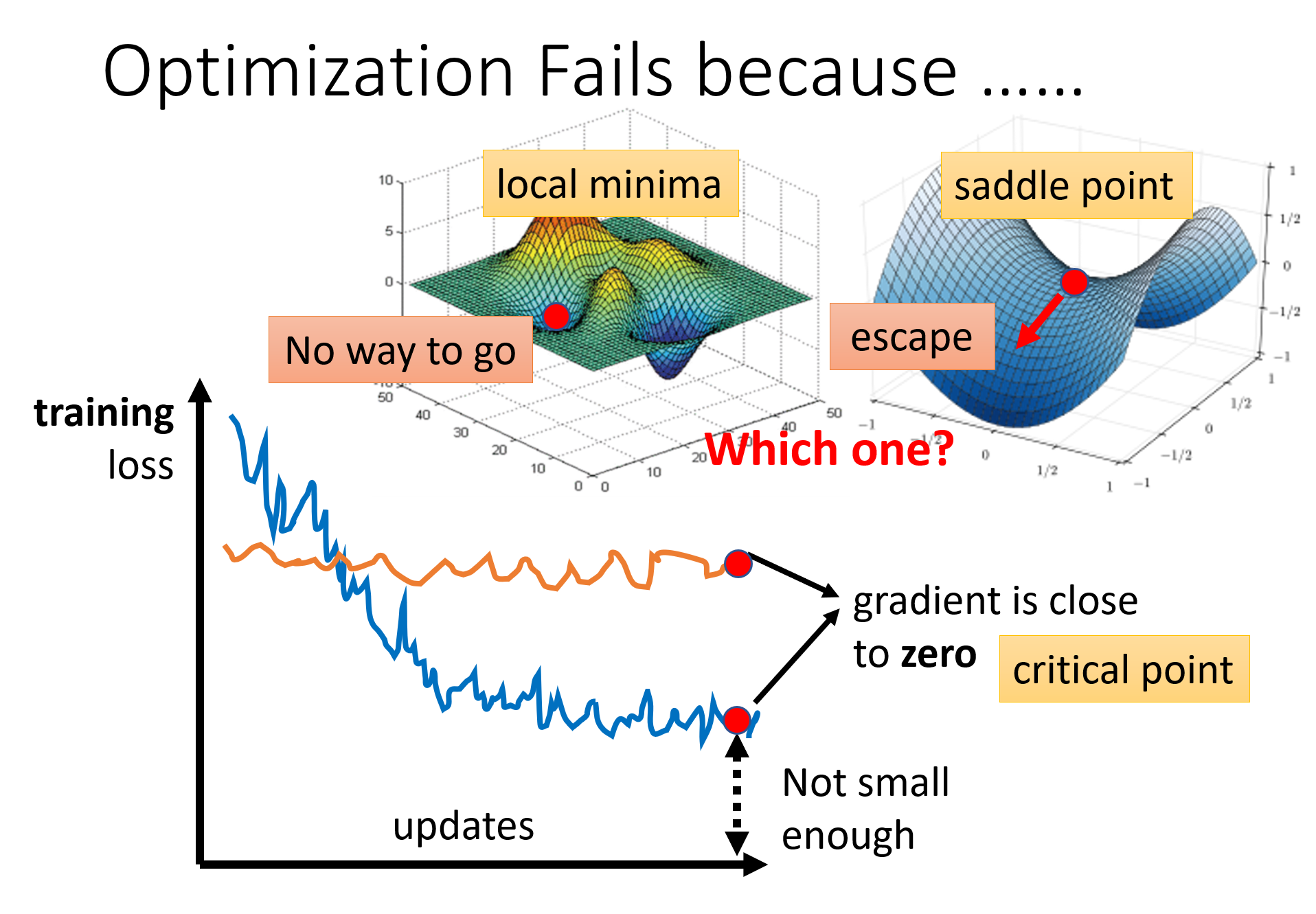

Problem: Critical point, Learning rate, Loss function

Solution: More powerful optimization technology, like Mini-batch, Momentum; AdaGrad, RMSProp, Adam, AdamW; Learning rate scheduling; Choose appropriate loss function

Taylor Series Approximation: 能够将任意光滑函数近似为多项式函数,其利用函数在某一点的值及其在该点的所有阶导数来构建一个多项式,这个多项式在该点附近与原函数的值非常接近。

$$ f(x) = f(a) + \frac{f'(a)}{1!}(x-a) + \frac{f''(a)}{2!}(x-a)^2 + \frac{f'''(a)}{3!}(x-a)^3 + \cdots \ or \ f(x) = \sum_{n=0}^{\infty} \frac{f^{(n)}(a)}{n!}(x-a)^n $$Hessian Matrix: 对于一个高维函数 \(f(x_1, x_2, \ldots, x_n)\),矩阵中将包含所有变量对之间的二阶偏导数,即对于 \(i\) 个 row 和 \(j\) 个 column 的 \(x_i\) 和 \(x_j\) 来说:

\[H = \begin{bmatrix} \frac{\partial^2 f}{\partial x_1^2} & \frac{\partial^2 f}{\partial x_1 \partial x_2} & \cdots & \frac{\partial^2 f}{\partial x_1 \partial x_n} \\ \frac{\partial^2 f}{\partial x_2 \partial x_1} & \frac{\partial^2 f}{\partial x_2^2} & \cdots & \frac{\partial^2 f}{\partial x_2 \partial x_n} \\ \vdots & \vdots & \ddots & \vdots \\ \frac{\partial^2 f}{\partial x_n \partial x_1} & \frac{\partial^2 f}{\partial x_n \partial x_2} & \cdots & \frac{\partial^2 f}{\partial x_n^2} \end{bmatrix} \ or \ H_{ij} = \frac{\partial^2f}{\partial{x_i}\partial{x_j}}\]P.S. 相对应的 Gradient 为 \(\boldsymbol{g} = \begin{bmatrix} \frac{\partial{f}}{\partial{x_1}} \\ \frac{\partial{f}}{\partial{x_2}} \\ \vdots \\ \frac{\partial{f}}{\partial{x_n}} \end{bmatrix}\)

Saddle Point: 对于多变量函数的函数图像,在 Saddle Point 上,函数在某些方向上局部最小,而在其他方向上局部最大。

Gradient is close to zero (training loss did not decrease or is not small enough) caused by meeting critical point (local minima or saddle point)

\[L(\boldsymbol{\theta}) \approx L(\boldsymbol{\theta'}) + (\boldsymbol{\theta} - \boldsymbol{\theta'})^T\boldsymbol{g} + \frac{1}{2} (\boldsymbol{\theta} - \boldsymbol{\theta'})^T H (\boldsymbol{\theta} - \boldsymbol{\theta'})\]这里的零阶项是损失函数在 \(\boldsymbol{\theta'}\) 点的值,一阶项反映的是损失函数在 \(\boldsymbol{\theta'}\) 点的线性变化(Gradient/一阶微分),二阶项反映的是损失函数的局部曲率(Hessian/二阶微分)。在 critical point 上,Gradient 项为零,所以要根据 Hessian matrix 来判断。如果二阶项大于零,则在 \(\boldsymbol{\theta'}\) 附近有 \(L(\boldsymbol{\theta}) > L(\boldsymbol{\theta'})\),即说明 \(\boldsymbol{\theta'}\) 点是一个 local minima,计算上只需要算出 Hessian matrix 的 eigenvalue,应有所有的 eigenvalue 都是正的。同理,如果所有的 eigenvalue 都是负的,则为 local maxima。如果 eigenvalue 有正有负,则为 saddle point。

L2 Norm (Euclidean Norm): \(\Vert\boldsymbol{x}\Vert_2 = \sqrt{x_1^2 + x_2^2 + \cdots + x_n^2}\)

L1 Norm (Manhattan Norm): \(\Vert\boldsymbol{x}\Vert_1 = \vert x_1 \vert + \vert x_2 \vert + \cdots + \vert x_n \vert\)

L-infinity Norm: \(\Vert \boldsymbol{x} \Vert_\infty = \max(\vert x_1 \vert, \vert x_2 \vert, \ldots, \vert x_n \vert)\),常被用来限制向量的最大变化量。在对抗性机器学习中,常用于衡量对抗性扰动的强度,确保这些扰动在每个维度上的最大改变不会超过某个预设的阈值。

计算量大,不会这么做!如果遇到 saddle point,只需要找出负的 eigenvalue(\(\lambda < 0\)),再找到相对应 \(H\) 的 eigenvector \(\boldsymbol{u}\),然后得到新的点 \(\boldsymbol{\theta} = \boldsymbol{\theta'} + \boldsymbol{u}\),这个点的 loss \(L\) 就会更小(\(\frac{1}{2} (\boldsymbol{\theta} - \boldsymbol{\theta'})^T H (\boldsymbol{\theta} - \boldsymbol{\theta'}) = \boldsymbol{u}^TH\boldsymbol{u} = \boldsymbol{u}^T(\lambda\boldsymbol{u}) = \lambda\Vert\boldsymbol{u}\Vert_2^2 < 0 \rightarrow L(\boldsymbol{\theta}) < L(\boldsymbol{\theta'})\))。

When you have lots of parameters, perhaps local minima is rare? 在低维度看起来是 local minima,但是在更高维度上更有可能是 saddle point,即 local minima 需要满足在各个维度上都是最小(很难做到)。所以当 Training loss 卡在某一个位置时,往往是遇到了 saddle point,而不是 local minima。

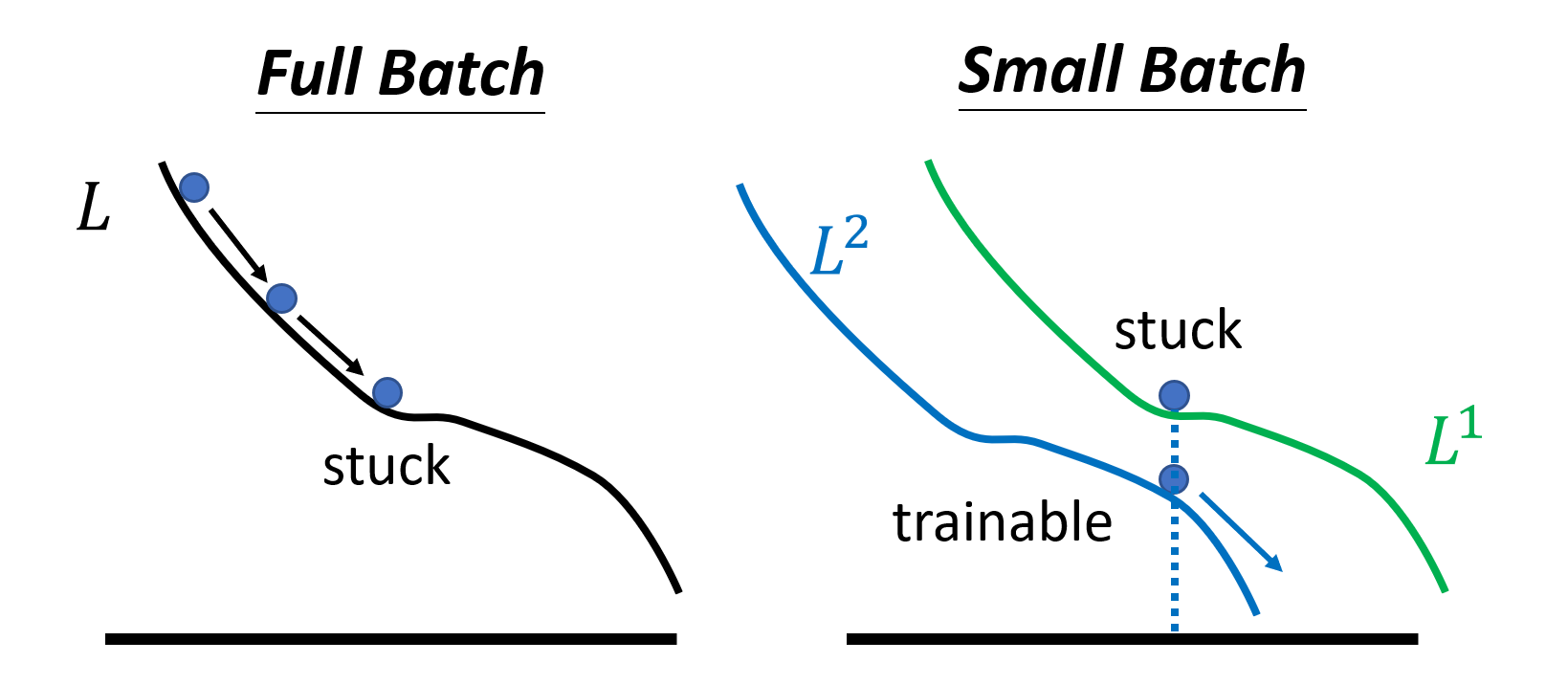

Mini-batch and Momentum can help escape critical points.

-

Mini-batch

将 Training data 划分 batch 的时候需要做 shuffle,一个常见的做法是在每个 epoch 开始之前进行划分,使得每一个 epoch 的 batch 都不一样。

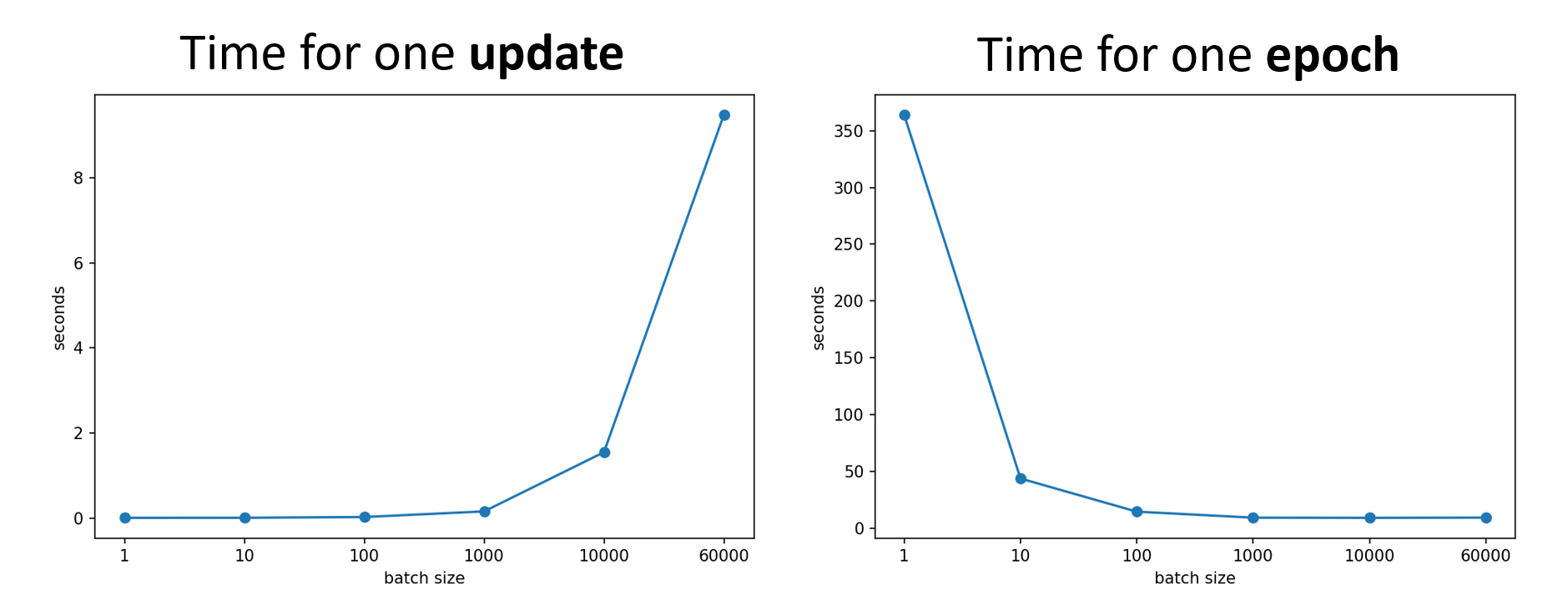

在使用 GPU 并行运算的条件下,smaller batch requires longer time for one epoch (seeing all data once)

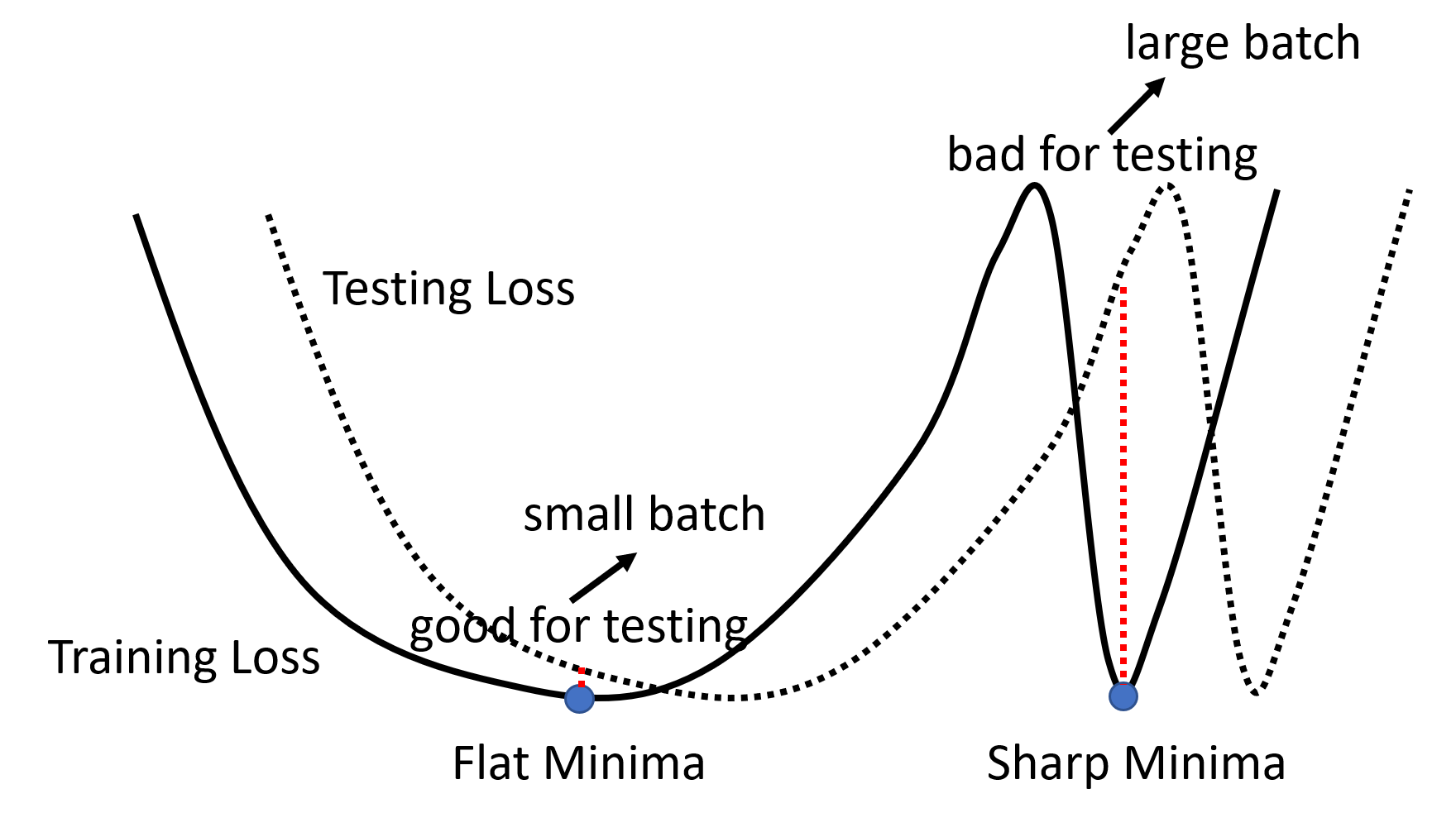

But smaller batch has better performance on training data and testing data (below is one of the explanations)

| Small Batch | Large Batch | |

|---|---|---|

| Time for one epoch | Slower | Faster |

| Gradient | Noisy | Stable |

| Optimization | Better | Worse |

| Generalization | Better | Worse |

总的来说,就是要调整 batch size 这个超参数来做取舍以达到想要的效果(当然也有可能做到鱼与熊掌兼得)。

Momentum

Optimization is not just based on gradient, but previous movement (movement is movement of the last step minus gradient at present).

Movement \(\boldsymbol{m^i}\) is the weighted sum of all the previous gradient: \(\boldsymbol{m^0} = 0, \ \boldsymbol{m^1} = \lambda\boldsymbol{m^0} -\eta\boldsymbol{g^0} = -\eta\boldsymbol{g^0}, \ \boldsymbol{m^2} = \lambda\boldsymbol{m^1} - \eta\boldsymbol{g^1} = -\lambda\eta\boldsymbol{g^0} - \eta\boldsymbol{g^1}\) (\(\lambda\) is also a hyperparameter) and parameter \(\boldsymbol{\theta}\) updated by

\[\begin{gather*} \boldsymbol{m^i} = \lambda\boldsymbol{m^{i-1}} - \eta\boldsymbol{g^{i-1}} \\ \boldsymbol{\theta^i} = \boldsymbol{\theta^{i-1}} + \boldsymbol{m^i} \end{gather*}\]因此,参数的更新方向不是完全按照当前 iteration 的 gradient 的方向,而是按照过去所有 gradient 的方向的总和作为更新的方向。

P.S. 这里的 momentum \(\boldsymbol{m}\) 写作是 gradient \(\boldsymbol{g}\) 的反方向,但是像 Adam 论文中写的是 \(\boldsymbol{m}\) 与 \(\boldsymbol{g}\) 同方向,所以更新参数 \(\boldsymbol{\theta}\) 时要减去 \(\boldsymbol{m}\)。

Adaptive Learning Rate

Convex error surface (Error Surface describes the relation between loss and parameters) is an ideal situation that has a clear global minima.

训练停滞不一定是由于 critical point (small gradient),也可能是 learning rate 的原因。

Different parameters needs different learning rate, if gradient is small, learning rate needs to be larger, vice versa.

-

AdaGrad: Add a parameter dependent parameter \(\sigma\) to adjust learning rate in gradient descent formulation. For \(i\)-th parameter \(\boldsymbol{\theta_i^t}\), if gradient is small in \(i\)-th iteration, then \(\sigma_i^t\) is also small, so learning rate will be larger. Hence, learning rate can be adjusted automatically.

\[\begin{gather*} \boldsymbol{\theta_i^{t + 1}} \leftarrow \boldsymbol{\theta_i^t} - \frac{\eta}{\sigma_i^t}\boldsymbol{g_i^t} \\ \sigma_i^t = \sqrt{\frac{1}{t + 1}\sum\limits^t_{i=0}(\boldsymbol{g_i^t})^2} \end{gather*}\]

Root Mean Square (RMS): \(\text{RMS} = \sqrt{\frac{1}{n} \sum_{i=1}^{n} x_i^2}\)

-

RMSProp: AdaGrad 默认每一个 gradient 都有同等的重要性(且会记住过去所有的梯度),在此基础上 RMSProp 做出改进在参数 \(\sigma_i^t\) 中引入另一个超参数 \(\alpha\),从而可以调整当前 iteration 的 gradient 的重要性(选择性地遗忘过去的梯度)。1

\[\sigma_i^t = \sqrt{\alpha(\sigma_i^{t-1})^2 + (1 - \alpha)(\boldsymbol{g_i^t})^2}, \ 0 < \alpha < 1\] -

Adam: RMSProp + Momentum, Momentum decides the direction of update and RMSProp decides the step size of update. And Adam also needs warm up.

Adam Paper 建议使用 PyTorch 预设的参数即可

-

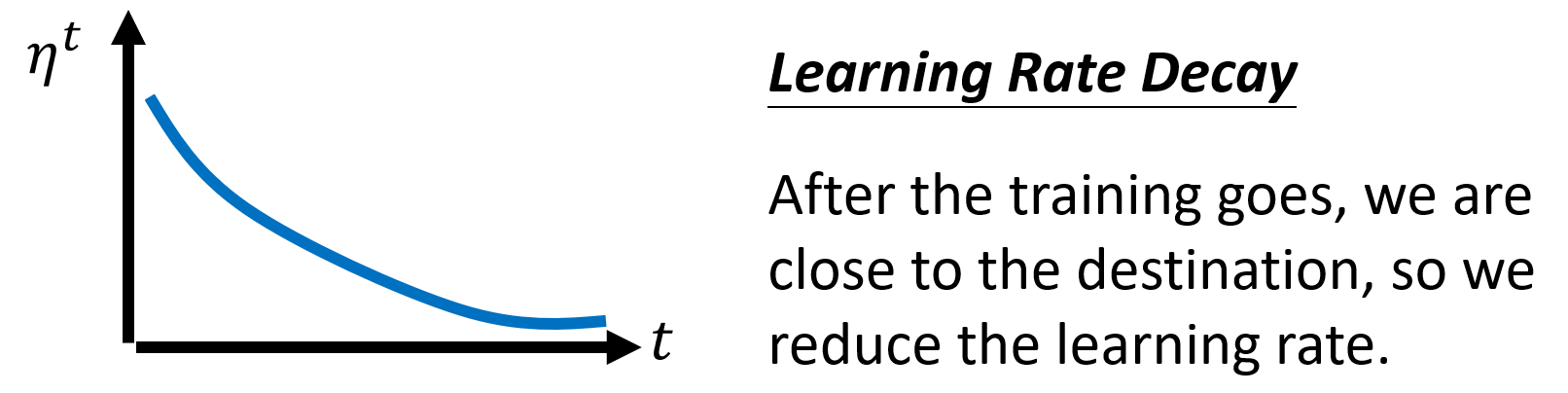

Learning Rate Scheduling: 令学习率随着时间变化,即 \(\eta \rightarrow \eta^t\)

-

Learning Rate Decay

-

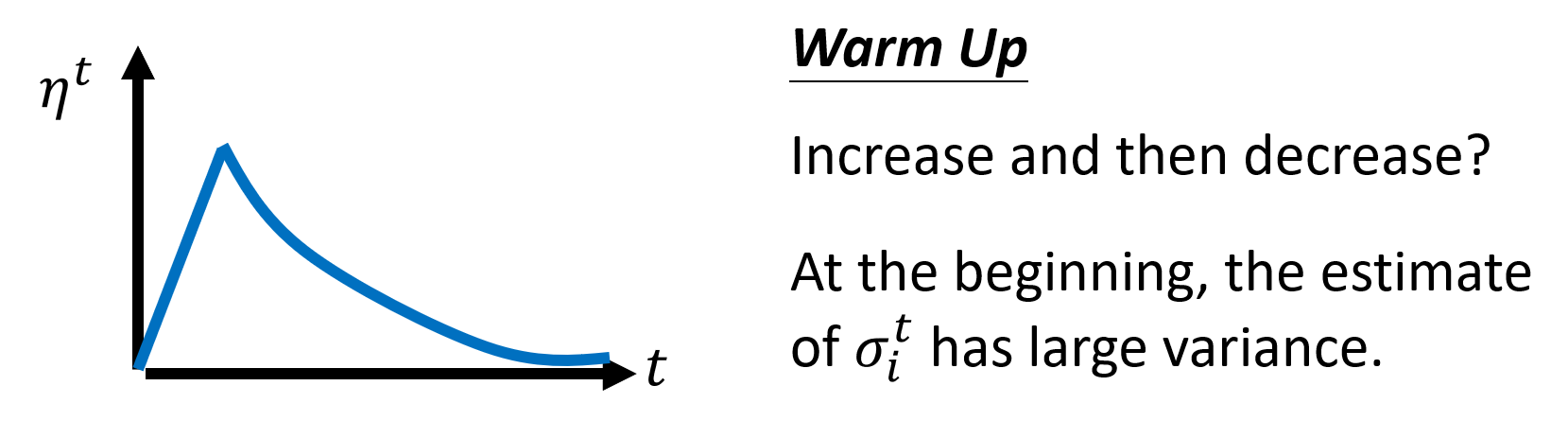

Warm Up

Warm Up is used in Residual Network, Transformer, BERT, 比较玄学,更多理解见 RAdam

The shape of the curve is like human life, up and down.

-

Determine it’s caused by model bias or optimization:

- Gaining the insights from comparison.

- Start from shallower networks (or linear model, SVM, Tree model, etc.), which are easier to optimize.

- If deeper networks do not obtain smaller loss on training data, then there is optimization issue.

-

Training loss is small, testing loss is large

-

Overfitting

Solution:

- Searching more training data

- Data augmentation (Creating new data based on the understanding of the problem and the characteristics of data, but need to be reasonable in the real world (like flipping an image horizontally instead of vertically, because the former does not affect the recognition of objects within the image))

- Constraining model

- Less parameters, sharing parameters

- Less features

- Early stopping

- Regularization

- Dropout

-

Mismatch

Training data and test data have different distributions. Be aware of how data is generated.

-

Trade-off:将 Training set 分为 Training set 和 Validation set,用前者拟合得到模型,根据模型在后者上的结果来选择模型,最后在 Test set 上评估。(尽量)不要用 Test set 上的结果去调整模型。最好的就是直接选择 Validation set 上 loss 最小的模型。P.S. 这里的 Validation set 要具有足够的代表性(保证分布一致)。如果担心单一验证集会过于乐观或代表性不足,也可以用 N-fold Cross-Validation,但这里最后就要用全部的 Training set 来拟合模型。

Classification

为保证分类的各类别之间距离相等(无特定关系),需要用 one-hot vector 来表示类别。

\[\text{softmax} = \frac{\exp(y_i)}{\sum_j\exp(y_j)}\]

通常在分类的最后要加一层 softmax,目的是将输出归一化(各个输出都介于 0 到 1 之间,且它们的和为1),然后再计算输出与 label(one-hot 形式)之间的距离(用 Cross-entropy 来计算 loss)。特别地,当二分类时,用 softmax 和 sigmoid 的效果是一样的。

Posterior Probability(后验概率):是指在已知某一事件发生的条件下,另一事件发生的概率,它是 Bayes’ Theorem(贝叶斯定理)的核心概念,通常用来在给定观测数据后更新我们对一个假设的可能性的评估,从而为下一步的决策提供依据。此外,后验概率的分布还可以作为不确定性的度量,概率分布如果集中某一类别上则表示模型非常确信其预测,而概率分布如果较为平坦则表示模型对其预测相对不确定。贝叶斯定理的公式:\(P(B_i \parallel A) = \frac{P(B_i)P(A \parallel B_i)}{P(A)} = \frac{P(B_i)P(A \parallel B_i)}{\sum^n_{i=1}P(B_i)P(A \parallel B_i)}\)。其中,\(P(B_i)\) 是 Prior Probability (先验概率),即在没有观测到数据之前认为假设 \(B_i\) 为真的概率;\(P(B_i \parallel A)\) 是后验概率,即观测到数据 \(A\) 出现后认为假设 \(B_i\) 为真的概率;\(P(A \parallel B_i)\) 是 Likelihood(似然),即在假设 \(B_i\) 为真的条件下,观测到数据 \(A\) 的概率;\(P(A)\) 是数据 \(A\) 出现的总概率,保证概率的归一化。

Likelihood 是从果到因考虑问题(给定结果,求导致这个结果的原因的可能性)。

神经网络的原始输出经过 softmax 函数处理后,可以被转换为概率分布,这里每个类别的输出概率可以被解释为在给定输入数据的条件下,该类别为正确类别的后验概率。为什么是后验概率?因为这些概率反映了模型基于当前观测到的数据对每个类别正确性的评估。

Cross-entropy: \(e = - \sum_i\hat{y_i} \ln y_i\), minimizing cross-entropy is equivalent to maximizing likelihood.

For classification tasks, cross-entropy is better than MSE (easy to train). In PyTorch, torch.nn.CrossEntropyLoss 自动包含了 softmax 操作,即在使用时会先对模型的输出应用 softmax 函数,再计算交叉熵损失,因此不需要在模型的最后一层手动添加 softmax 激活函数,模型的最后一层输出应直接是未经 softmax 处理的 logits。

因此,改变 loss function 也可以优化 optimization(change the landscape of error surface)。

Optimizers for DL

Optimizers: SGD, SGD with momentum (SGDM), AdaGrad, RMSProp, Adam, AdamW (Hugging Face BERT)

Adam v.s. SGDM

Adam: Fast Training, Large Generalization Gap, Unstable, Possibly Non-convergence, Suitable for NLP, GAN, RL

SGDM: Slow Training, Small Generalization Gap, Stable, Better Convergence, Suitable for CV

Something may help optimization:

-

Increase Randomness (More Exploration)

Shuffle, Dropout, Gradient Noise

-

Start from easy

Warm Up, Curriculum Learning, Fine-tuning

-

Normalization, Regularization

AdamW:在 Adam 中,权重衰减通常是通过在损失函数中加入一个正则项(L2 惩罚)来实现的。在参数更新公式中,这种方式导致权重衰减会受到学习率的影响。而 AdamW 将权重衰减从梯度更新过程中分离出来,允许权重衰减独立于自适应学习率,使其仅依赖于设定的衰减系数,这种方法更接近传统的权重衰减,从而可以提高训练过程的稳定性,并且在一些任务中,如训练深层网络或复杂的模型时,表现得更好。

Tips for DL

DL 其实不容易 Overfitting,像 KNN、Decision Tree 这样的 ML 模型很容易就会在训练集上达到 100% 的 accuracy,这才叫容易 Overfitting。DL 第一个遇到问题最可能是在训练集上根本 train 不起来,accuracy 很低。在训练集上结果好后,再在验证集上评估如果效果差,如果用某些技术解决了 Overfitting 但是发现训练集又变坏了,那就需要再调整让训练集变好,如此反反复复直到在训练集和验证集上表现都足够好。

Activation Function

ReLU:\(f(x) = \max(0, x)\) 目前比较常用,其优点为计算速度快且可以解决 vanishing gradient problem。

LeakyReLU:\(f(x) = \begin{cases} x & \text{if } x > 0 \\ \alpha x & \text{if } x \le 0 \end{cases}\),\(\alpha\) 是一个很小的正数(例如 0.01),有助于避免神经元死亡问题,这使得在训练过程中保持网络的梯度流动。

Early Stopping

如果训练集的 loss 还在下降,但验证集的 loss 反而开始回升,此时应该提前停止训练。

Regularization

Modify the loss function

L2-regularization:\(L_{l_2}(\boldsymbol{\theta}) = L(\boldsymbol{\theta}) + \frac{\lambda}{2} \Vert \boldsymbol{\theta} \Vert^2_2\),L2 正则化通过在损失函数中添加一个正则化项来实现,这个正则化项由于是平方项,所以对于较大的参数值会更敏感,从而增大对较大参数值的惩罚(即优化算法会增大参数减小的幅度,以最小化总损失)。因此,L2 正则化能够防止模型过于复杂,有利于防止过拟合。

更新的过程就变为:\(\theta \leftarrow \theta - \eta \frac{\partial L_{l2}}{\partial \theta} = \theta - \eta (\frac{\partial L}{\partial \theta} + \lambda \theta) = (1 - \eta \lambda)\theta - \eta \frac{\partial L}{\partial \theta}\),\((1 - \eta \lambda)\theta\) 这一项由于 \(\theta\) 会乘上一个很接近于 1 但小于 1 的值,所以会越来越小趋近于 0,因此也被称为 Weight Decay。

Dropout

适用于训练集表现好但验证集表现不好的情况下。

在用每一个 mini-batch 做每一次 update 之前都要重新采样要 dropout 的 neuron,因此每一次 update 用来训练的 network structure 是不同的。Dropout 会让训练的性能变差,但是目标是提升测试(validation)的性能。在测试(validation)时则保留全部的 neuron,需要注意的是,如果训练时 dropout 的比例是 \(p\%\),那测试时的所有权重都要乘上 \((1-p)\%\)。

Dropout is a kind of ensemble.

3. CNN

Image \(\rightarrow\) 3-D tensor (width, height and channel), every pixel of an image is composed of 3 colors (RGB), so 3 channels represent RGB.

Fully Connected Layer: 网络中的每个神经元都与前一层的每一个神经元相连接,在全连接层中,输入的所有特征都会被考虑在内,输入的每个特征都会对每个输出产生影响。全连接层通常用于网络的最后几层,将前面层输出的特征进行汇总和非线性组合,以执行分类、回归或其他任务(数学运算就是矩阵乘法加上偏置项,通常后接一个非线性激活函数)。

Observation 1

只需要对 neuron 输入图像的某一小部分来判断是否具有某些重要的具有代表性的 pattern 即可判断图像中的物体,而不需要每个 neuron 都去看完整的图像。

Same patterns are much smaller than the whole.

Simplification 1

Typical Receptive Field Setting for Simplifying Fully Connected Network

- Each receptive field has a set of neurons (e.g., 64, 128).

- Stride (e.g., 1, 2) controls the movement step size of the receptive field and it’s best to have overlap between receptive fields.

- Padding fills the edges of the image with zeros or other values to control the size of the whole image.

Observation 2

同样的 pattern 可能会出现在不同图像的不同区域,识别同样 pattern 的 neuron 做的事情其实是一样的,只是它们负责的 Receptive Field 有所不同。

The same patterns appear in different regions.

Simplification 2

Parameter Sharing for Different Receptive Fields. Typical setting is that each receptive field has the neurons with the same set of parameters (A set of parameters is called a filter).

Statement 1

Receptive Field + Parameter Sharing = Convolutional Layer (Lower complexity than Fully Connected Layer, and lower risk of overfitting, but larger model bias)

Statement 2

\[\text{Image} \xrightarrow[]{\text{Convolutional Layer}} \text{Feature Map}\]If convolutional layer has 64 filters, feature map can be seen as “image” with 64 channels (image from 3 channels to 64 channels, i.e., convolution). 每一个卷积层中的 filter 的 channel 数需要等于输入的 image/”image“ 的 channel 数。

Statement 1 and 2 are Same story: The values of filters in statement 2 are the same as parameters (weight and bias) of neurons in statement 1, so when a filter sweeps across the image (i.e., convolution), it’s equal to sharing parameters.

Observation 3

Subsampling the pixels will not change the object \(\longrightarrow\) Pooling

Pooling decreases the width and height of the image.

Pooling 在 Convolution 之后使用,并且两者通常交替使用,比如做一次/几次 Convolution 做一次 Pooling。Pooling 主要目的是降低计算量,但是如果识别/侦测的是非常微细的东西,Pooling 所做的 Subsample 可能会对性能有所伤害,要考虑具体应用场景来决定是否要对 network 做 Pooling。

要得到最终的结果,需要对 Pooling 的输出做 Flatten(把矩阵拉直,变成一个向量),再输入到 FC Layer 中,最后再经过 softmax。

Convolutional layer is specifically designed for images, if it’s used for other tasks, need to consider whether these tasks have characteristics similar to images.

But CNN is not invariant to scaling and rotation, so we need data augmentation.

4. Self-attention

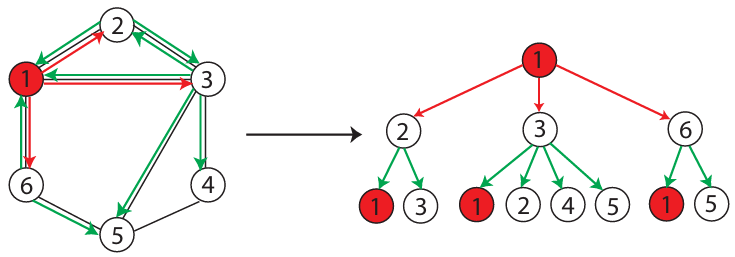

Self-attention is to consider the information of the whole sequence

Vector Set as Input and What is the Output

- Each vector has an output label

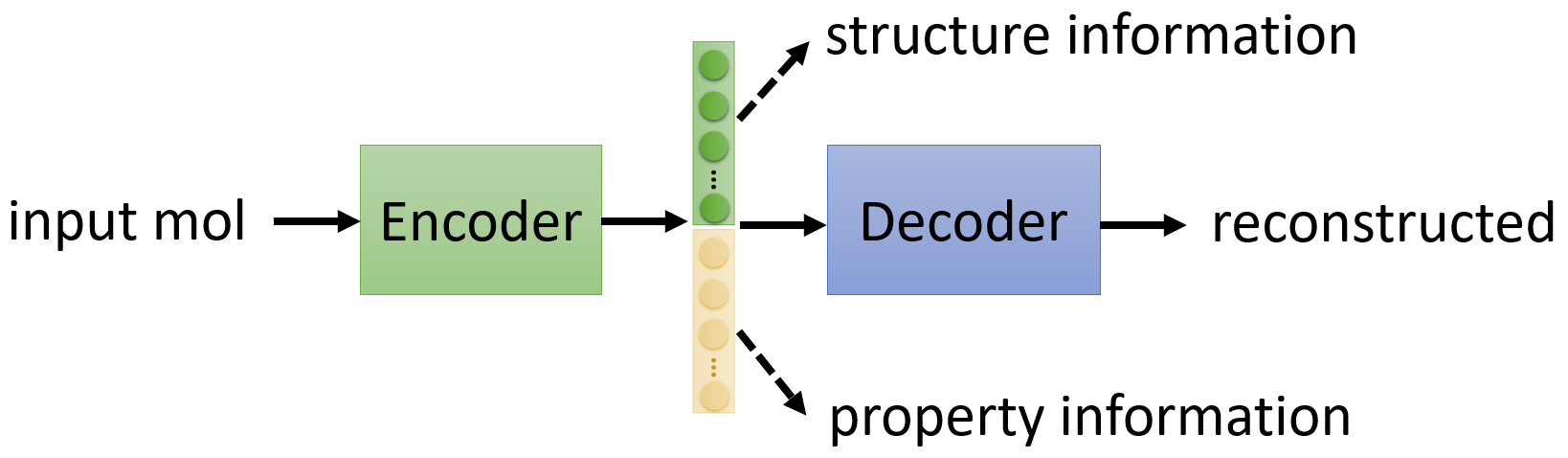

- The whole sequence has an output label (e.g., Input molecular graph and output molecular property)

- Model decides the number of output labels itself (e.g., Seq2seq)

Dot Product: \(\mathbf{A} \cdot \mathbf{B} = a_1b_1 + a_2b_2 + \ldots + a_nb_n = \sum_{i=1}^{n} a_i b_i\)

Input of Self-attention can be either input of the whole network or output of a hidden layer

输入向量两两之间相互的关联程度/相似性用 \(\alpha\) 来表示,可以通过计算两个向量的点积(点积可以衡量两个向量在各个维度上的值的匹配程度)来得到,点积结果大即关联程度高。

\[\boldsymbol{q^1} = \boldsymbol{a^1}W^q, \ \boldsymbol{k^2} = \boldsymbol{a^2}W^k \longrightarrow \alpha_{1,2} = \boldsymbol{q^1} \boldsymbol{\cdot} \boldsymbol{k^2}\]如果有四个输入向量 \(\boldsymbol{a^i}, \ i=1,2,3,4\),以第一个向量 \(\boldsymbol{a^1}\) 为例,会计算出 \(\alpha_{1,2}, \ \alpha_{1,3}, \ \alpha_{1,4}\) 以及通常还会有自身与自身的关联程度 \(\alpha_{1,1}\),然后通过 softmax(也可为其他的激活函数) 得到 \(\alpha'\)。然后对每一个输入向量乘上一个 \(W^v\),再根据 attention scores 来提取信息得到 \(\boldsymbol{b^1}\)。P.S. \(\boldsymbol{b^i}, \ i=1,2,3,4\) 是同时计算出来的,而不是依次。

\[\begin{gather*} \boldsymbol{v^i} = \boldsymbol{a^i}W^v, \ i=1,2,3,4 \\ \boldsymbol{b^j} = \sum\limits_i\alpha'_{j,i}\boldsymbol{v^i}, \ j=1,2,3,4 \end{gather*}\]值得注意的是,这其中只有 \(W^q, W^k, W^v\) 是需要从训练数据中学习的。

P.S. \(\boldsymbol{q}\) is query, \(\boldsymbol{k}\) is key, \(\boldsymbol{v}\) is value, and \(\alpha\) is attention score.

Multi-head Self-attention

以 2 heads 和 2 input \(\boldsymbol{a^i}, \boldsymbol{a^j}\) 为例,原本 \(\boldsymbol{a^i}\) 所对应的 \(\boldsymbol{q^i}\) 变成 \(\boldsymbol{q^{i,1}}, \boldsymbol{q^{i,2}}\),即 \(\boldsymbol{q^{i,1}} = W^{q,1}\boldsymbol{q^i}, \ \boldsymbol{q^{i,2}} = W^{q,2}\boldsymbol{q^i}\),然后在计算输出的时候每一 head 会分开计算。head 1的计算公式为 \(\boldsymbol{b^{i,1}} = \text{softmax}(\boldsymbol{q^{i,1}} \boldsymbol{\cdot} \boldsymbol{k^{i,1}})\boldsymbol{v^{i,1}} + \text{softmax}(\boldsymbol{q^{i,1}} \boldsymbol{\cdot} \boldsymbol{k^{j,1}})\boldsymbol{v^{j,1}}\)。得到每一 head 的输出后,将这些输出 concatenate \([;]\),然后通过另一个线性变化 \(W^O\) 整合不同 head 的信息来得到最终的输出 \(\boldsymbol{b^i} = W^O [\boldsymbol{b^{i,1}}; \boldsymbol{b^{i,2}}]\)。

Positional Encoding

如果输入的 sequence 的每个元素的位置信息很重要,可以给输入 \(\boldsymbol{a^i}\) 添加一个 unique positional vector \(\boldsymbol{e^i}\),它可以是 hand-crafted 的,也可以是 learned from data。Paper

Self-attention for a long sequence

If sequence is very long, there need large momery to storage the attention matrix.

Truncated Self-attention

对于 sequence 中的某个/些元素只需要看一定范围内的 attention 即可,而不是看整个 sequence。

Self-attention v.s. CNN

- CNN: Self-attention that can only attends in a receptive field (CNN is simplified self-attention)

- Self-attention: CNN with learnable receptive field (Self-attention is the complex version of CNN)

CNN is a subset of Self-attention. But more flexible model needs more training data to perform better.

Self-attention v.s. RNN

Timestamp - 35:12 Self-attention is parallel.

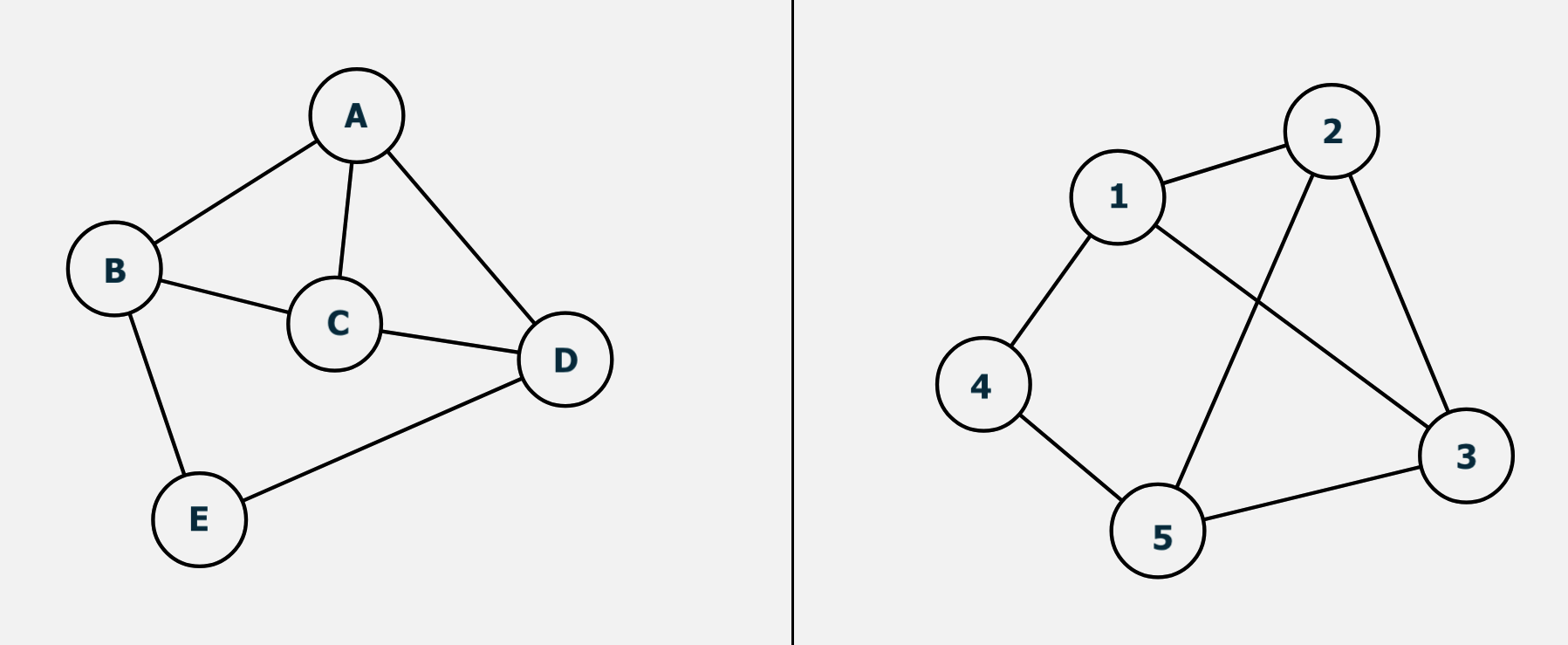

Self-attention for Graph

考虑到 edge 的存在,可以不再需要 model 自己学习 node 之间的关联性,只计算有 edge 相连的 node 之间的 attention 即可。相当于 graph 其实就已经是建立在 domain knowledge 之上的。

Self-attention 的缺点是计算量比较大。

5. Transformer

Batch Normalization

-

Batch Normalization - Training

Batch Normalization can do optimization by changing the landscape of error surface (also the loss function part mentioned above)

如果 feature 的不同 dimension 的 scale 差距很大,就会导致 error surface 在不同方向上的斜率非常不同。如果可以让不同的 dimension 有同样的数值范围,可能就会得到比较好的 error surface,让 training 变得更容易/更快

Feature Normalization: For features \(\boldsymbol{x^1}, \boldsymbol{x^2}, \boldsymbol{x^3}, \cdots, \boldsymbol{x^r}, \cdots, \boldsymbol{x^R}\), and for each dimension \(i\), the mean is \(\mu_i\) and the standard deviation is \(\sigma_i\). So the means of all dims are 0, and the stds are 1, \(\tilde{\boldsymbol{x}}\boldsymbol{^r_i} \leftarrow \frac{\boldsymbol{x^r_i} - \mu_i}{\sigma_i}\). Feature Normalization can make gradient descent converge faster.

Converge(收敛):某个过程随着时间的推移逐渐稳定到某个固定值或状态。

当对输入 \(\tilde{\boldsymbol{x}}^\boldsymbol{1}\) 做 Feature Normalization 后通过 \(W^1\) 得到的 \(\boldsymbol{z^1}\) 同样也需要做 Feature Normalization 来保证不同的 dims 有同样的 range,然后再通过激活函数得到这一层的输出 \(\boldsymbol{a^1}\)。这里的 Feature Normalization 通常是在激活函数之前做,也就是对 \(\boldsymbol{z^i}\) 做,即 \(\tilde{\boldsymbol{z}}^\boldsymbol{i} \leftarrow \frac{\boldsymbol{z^i} - \boldsymbol{\mu}}{\boldsymbol{\sigma}}\)(由于是向量,相减相除都是 element-wise 的)。

\(\leftarrow\) 代表赋值(assignment)

由于在训练时通常考虑的是一个 batch,而不是整个 training set,所以也称作 Batch Normalization。

由 \(\boldsymbol{z^i}\) 得到的 \(\tilde{\boldsymbol{z}}^\boldsymbol{i}\) 的 mean 一定是 0,这会对 network 产生一些限制,可能会有未知的负面影响,所以再加回参数 \(\boldsymbol{\gamma}, \boldsymbol{\beta}\) 来让 network 自己学习调整输出的分布,即 \(\hat{\boldsymbol{z}}^{\boldsymbol{i}} \leftarrow \boldsymbol{\gamma}\odot\tilde{\boldsymbol{z}}^\boldsymbol{i} + \boldsymbol{\beta}\)。通常 \(\boldsymbol{\gamma}, \boldsymbol{\beta}\) 的初始值分别为 ones vector 和 zeros vector。

-

Batch Normalization - Testing

在测试时,由于 Batch Normalization 需要一个 batch 的数据来计算 \(\boldsymbol{\mu}\) 和 \(\boldsymbol{\sigma}\),但是当用户输入的时候,不可能每次都是恰好一个 batch size 的数据,这时在 PyTorch 中,采用的策略是在训练时每一个 batch 的 \(\boldsymbol{\mu}\) 和 \(\boldsymbol{\sigma}\) 都会用来算 moving average(假如有 t 个 batch,\(\bar{\boldsymbol{\mu}} \leftarrow p\bar{\boldsymbol{\mu}} + (1-p)\boldsymbol{\mu^t}\),\(p\) 是超参数,默认为 0.1),然后用 \(\bar{\boldsymbol{\mu}}\) 和 \(\bar{\boldsymbol{\sigma}}\) 取代 \(\boldsymbol{\mu}\) 和 \(\boldsymbol{\sigma}\)。

Seq2seq

Input a sequence, output a sequence. The output length is determined by model (e.g., speech recognition, machine translation, speech translation, Question Answering

Question Answering (QA) can be done by seq2seq.

\[\begin{gather*} {\large \textbf{Seq2seq Architecture}} \\ \text{Sequence} \longrightarrow \text{Encoder} \longrightarrow \text{Decoder} \longrightarrow \text{Sequence} \end{gather*}\]Seq2seq’s Encoder

Input vectors, output vectors, i.e., \(\boldsymbol{x^1}, \boldsymbol{x^2}, \cdots, \boldsymbol{x^k} \xrightarrow[]{\text{Encoder}} \boldsymbol{h^1}, \boldsymbol{h^2}, \cdots, \boldsymbol{h^k}\)

Seq2seq’s Decoder

Autoregressive and Non-autoregressive

内部协变量偏移(Internal Covariate Shift):训练过程中网络各层的输入分布会随着上一层参数的更新而不断变化,使得网络各层需要不断适应新的输入分布,从而可能导致训练过程缓慢,需要更小的学习率和更细致的参数初始化策略。减少 Internal Covariate Shift 可以加快训练过程,使得模型更快收敛,同时也可以提高模型的训练稳定性,降低梯度爆炸或梯度消失的风险。

Layer Normalization: 独立地对每个样本的所有特征进行归一化,即对 \(\begin{bmatrix} x_1 \\ x_2 \\ \vdots \\ x_k \end{bmatrix}\) 求得 mean \(\mu\) 和 std \(\sigma\),然后通过 \(x_i' = \frac{x_i - \mu}{\sigma}\) 计算得到 \(\begin{bmatrix} x_1' \\ x_2' \\ \vdots \\ x_k' \end{bmatrix}\),可以减少 Internal Covariate Shift,同时也不像 BN 那样依赖于 batch size,适用于 batch size 较小或需要适应动态 batch size 的情况。

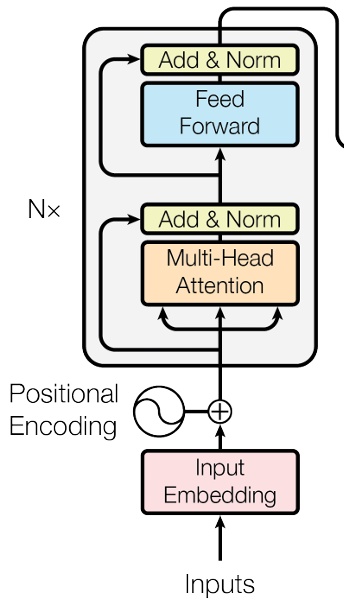

Transformer’s Encoder

- 输入需要做 Positional Encoding 后再输入到 Multi-Head Attention (Self-attention) 中;

- Self-attention 的每个 output vector 还需要再加上它的 input vector 来当作是新的 output,这样的操作叫做 residual connection;

- 然后这个新的 output 再去做 Layer Normalization;

- Layer Normalization 的输出再输入到 FC Network中,FC Network 在这里也有 residual 的架构;

- FC Network 的输出再做一次 Layer Normalization 作为 Transformer’s Encoder 的一个 block 的输出;

- Transformer’s Encoder 一共重复 N 次上述的 block。

BOS (begin of sentence):在 NLP 中,处理文本数据时常常需要明确标示句子的起始和结束位置。BOS 作为一个 token,帮助模型识别句子的开始。这对于训练语言模型、进行序列生成任务(如文本生成、机器翻译等)尤为重要,因为模型需要了解句子结构的边界以更准确地处理和生成文本。同理,EOS (end of sentence) 可以用来表示句子的结束。

token:通常指文本中的一个独立的、有意义的元素,是构成 sentence 的基本单位。在文本处理和分析中,原始文本经常会被分割成 tokens,以便于进一步的处理和分析。

Autoregressive (AR):基于过去的值来预测未来的值,逐步生成序列的每个元素。在 Autoregressive 模型中,每个时刻的输出不仅依赖于输入变量,还依赖于之前时刻的一个或多个输出。e.g., \(X_t = \alpha X_{t-1} + \epsilon_t\)

Non-autoregressive (NAR):一次性地生成整个序列(将整个输入序列一次性送入模型并利用并行计算的能力来同时处理序列中的所有位置),显著提高了生成速度。但是,由于模型可能难以捕捉序列中的长距离依赖关系,所以会牺牲一定的生成质量。

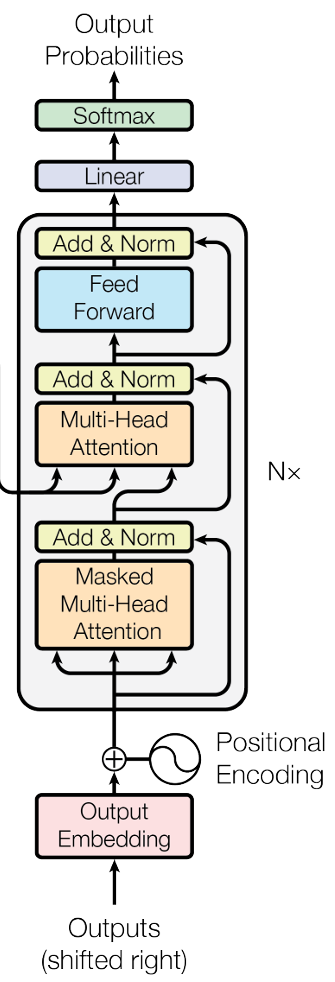

Transformer’s Decoder

-

Masked Self-attention:举例来说,当产生 \(\boldsymbol{b^2}\) 时,只用 \(\boldsymbol{q^2}\) 与 \(\boldsymbol{k^1}, \boldsymbol{k^2}\) 去计算 attention score,即每个位置只考虑当前和之前的 attention。

Why masked? Consider how does decoder work (i.e., Autoregressive). Decoder 看到的输入是它在前一个时间点自己的输出(初始从 BOS 开始),即 Self-attention 的 \(\boldsymbol{a^1}, \boldsymbol{a^2}, \cdots, \boldsymbol{a^i}\) 是 one by one 依次产生的,而不是原来的一次性输入全部。

最后,添加一个 “Stop Token” EOS,当 Decoder 输出 EOS 时整个程序结束,从而使得机器能够自行决定要输出的 sequence 的长度。

-

Autoregressive Transformer (AT) v.s. Non-autoregressive Transformer (NAT)

-

因为 NAT 是一次性输出整个序列,那么如何决定其输出序列的长度呢?

-

Another predictor for output length (在 Encoder 后加一个 classifier 来提前给出 Decoder 所输出的序列的长度)

-

Output a very long sequence, ignoring tokens after EOS

-

- Advantages: parallel, controllable output length

- Disadvantages: NAT is usually worse than AT

-

-

Cross Attention:Encoder 的输出 \(\boldsymbol{b^1}, \boldsymbol{b^2}, \cdots, \boldsymbol{b^i}\) 会产生 \(\boldsymbol{k^1}, \boldsymbol{k^2}, \cdots, \boldsymbol{k^i}\) 和 \(\boldsymbol{v^1}, \boldsymbol{v^2}, \cdots, \boldsymbol{v^i}\),Decoder 通过 Masked Self-attention 输出的向量会产生 Query \(\boldsymbol{q}\)。\(\boldsymbol{q}\) 与 \(\boldsymbol{k}\) 点乘得到 \(\alpha\),再与 \(\boldsymbol{v}\) 加权求和,所得到的向量再输入到 FC Network 中。在 Transformer 中,这里的 \(\boldsymbol{k}\) 和 \(\boldsymbol{v}\) 来自于 Encoder 的最后一层,\(\boldsymbol{q}\) 则来自于 Decoder 的当前层。这样的设置允许 Decoder 的每一层都能够访问到 Encoder 的全部信息。

Transformer’s Training

-

minimize cross entropy

- Teacher Forcing: using the ground truth as decoder’s input. 在早期阶段,可以有效地指导模型学习正确的输出模式,提高效率。但会导致 training 和 inference (testing) 存在一定的 Mismatch。因为在 inference 中,模型必须依赖于自己的输出来生成下一个词,所以模型会看到一些错误的东西,但在 training 中模型看到的始终是正确的。这个现象叫做 Exposure Bias,因此会导致在 inference 中,当模型遇到自己的预测是错误的时会表现不佳,因为它在训练过程中没有足够的机会去学习如何从自己的错误中恢复。Scheduled Sampling 可以通过逐渐地将模型自己的预测引入训练过程中来有效地缓解 Exposure Bias,具体来说,是在训练过程的不同阶段以一定的概率选择使用模型的预测输出而不是真实的上一个输出作为下一个时间步(Time Step)的输入,并且这个概率会随着时间逐渐增加,从而帮助模型在训练过程中逐渐适应其在实际应用中的使用情况。Transformer 并没有用 Scheduled Sampling,要想用的话需要更多的考虑。

- Training tips1 - Guided Attention: 引入额外的信息或约束来指导注意力的焦点(或引导注意力的分布,比如让注意力保持从左向右),使模型能够更有效地学习从输入到输出的映射关系。Guided Attention 通常通过在模型的损失函数中加入额外的项来实现,使得模型在训练过程中被鼓励学习符合这些引导的注意力分布,从而在特定任务上达到更好的性能。

- Training tips2 - Noise: 当需要机器有创造力时,可以在 Decoder 中加入随机性。在语音合成(Text-to-Speech, TTS)中,模型训练好后需要在测试时添加 Noise 才会让合成出来的声音更像人声(有点违背常理,因为 Noise 通常在训练时添加(e.g., Dropout),让机器看过更多的可能性,从而模型会更 robust)。

- Training tips3 - Optimization: When you don’t know how to optimize, just use Reinforcement Learning (RL)! (e.g., loss function is non-differentiable, considering loss function as reward and Decoder as agent)

6. Generation

Network as Generator

The input of the network is not only \(\boldsymbol{x}\), but \(\boldsymbol{x}\) and a random variable \(\boldsymbol{z}\), \(\boldsymbol{z}\) is randomly sampled from a distribution, and this distribution is simple enough, i.e., we know its formulation (e.g., Normal/Uniform). So the output of the network \(\boldsymbol{y}\) is a complex distribution. And the network here is called generator. The architecture of the generator is totally customizable. P.S. 这些简单的分布选择哪一个差异都不大,只要够简单就行,因为 generator 总是会将其对应到一个复杂的分布。

Especially for the tasks needs “creativity”. Because the same input \(\boldsymbol{x}\) can have different outputs \(\boldsymbol{y}\).

GAN

GAN 很强大但是局限性在于 unstable training。

本节的讨论都是基于 Unconditional generation: input without \(\boldsymbol{x}\)

Discriminator is actually a neural network (architecture is customizable) and its output is a scalar (larger means input is real, otherwise, it is fake).

Description

The discriminator’s function is to determine whether the input data is real or fake, the latter being generated by the generator. And the generator’s function is to generate fake data that is as close as possible to the real one. The two are adversarial, making each other stronger and stronger.

Step 1: Randomly Initialize the parameters of generator and discriminator.

For each iteration:

Step 2: Fix generator, and update discriminator. Firstly, sample some vectors from normal distributions (or others) as input to feed into generator, then generator generates some fake objects and we can also sample some real objects from database. Next discriminator learns to assign high scores to the real objects and low scores to the generated objects (Considered as classification or regression).

Step 3: Fix discriminator, and update generator. According to the scores output by discriminator, generator learns how to maximize the scores to the generated objects. 所以这里可以把 discriminator 输出的 score 加一个负号作为 loss,让 loss 越小越好,从而更新 generator 的参数。

Step 4: Repeat step 2 and 3, until both are good enough.

Divergence(散度):用于衡量两个概率分布(Probability Distribution)之间的差异或不一致性的程度。例如 KL 散度和 JS 散度都是通过比较两个分布在同一事件集上的概率值来量化分布之间的差异。

KL Divergence (Kullback-Leibler Divergence):也称为相对熵(Relative Entropy),对于两个概率分布 \(P\) 和 \(Q\),公式为 \(KL(P \parallel Q) = \sum_{x} P(x) \log \frac{P(x)}{Q(x)}\),\(x\) 表示每个事件。其中,对数部分用于衡量 \(P\) 和 \(Q\) 在每个事件上的相对差异,如果 \(P(x)\) 和 \(Q(x)\) 相等,那么表示两者在该事件上没有差异,则对数部分为 0。\(P(x)\) 则是事件 \(x\) 在分布 \(P\) 中发生的真实概率,如果这个概率很低,那么即使差异很大,它对总的 KL 散度的贡献也会较小。最后两者综合的结果表示从分布 \(P\) 到分布 \(Q\)(分布 \(P\) 相对于分布 \(Q\))的“信息损失”量,即 KL 散度量化了如果我们假设数据遵循分布 \(Q\) 而真实分布为 \(P\) 时,我们期望遭受的信息损失。KL 散度越大,意味着使用假设分布 \(Q\) 来近似真实分布 \(P\) 时会损失更多的信息。局限性:KL 散度是非对称(即 \(KL(P \parallel Q) \ne KL(Q \parallel P)\))的且无界的。

JS Divergence (Jensen-Shannon Divergence): 公式为 \(JS(P \parallel Q) = \frac{1}{2} KL(P(x) \parallel \frac{P(x) + Q(x)}{2}) + \frac{1}{2} KL(Q(x) \parallel \frac{P(x) + Q(x)}{2})\),相比于 KL 散度,JS 散度是对称且有界(当对数底数为 2 时,范围为 0 到 1)的。当两个概率分布完全相同时,即 \(P(x) = Q(x)\) 时,JS 散度为 0。当两个概率分布完全不相交(没有重叠)时,JS 散度达到最大值。可以理解为一个事件在一个分布中发生时(概率大于 0),在另一个分布中一定不发生(概率为 0)。JS 散度可以看作是基于平均分布的比较。JS 散度对于分布中的小变动(如噪声)通常也更加平滑(不敏感)。

Cross Entropy: \(H(P, Q) = -\sum_{x} P(x) \log Q(x)\),交叉熵常用作 NN 的损失函数来衡量概率分布 \(P\) 和 \(Q\) 之间的相似性。交叉熵与 KL 散度之间的关系:\(H(P, Q) = H(P) + KL(P \parallel Q)\)。因此,交叉熵不仅考虑了当使用分布 \(Q\) 来近似分布 \(P\) 时的信息损失(分布间差异导致的额外的不确定性),还考虑了分布 \(P\) 本身的不确定性。这意味着最小化交叉熵可以间接最小化预测分布与真实分布之间的 KL 散度,从而提高模型的预测准确性。

JS 散度倾向于比较两个分布的相似度,交叉熵倾向于优化一个模型,使其预测分布尽可能接近真实分布。

\(P(A \mid B)\) 读作 “P of A given B”

对于 Generator \(G\) 和其输出的分布 \(P_G\),以及真实数据的分布 \(P_{data}\),有

\[G^* = \arg \min\limits_G \text{Div}(P_G, P_{data})\]The objective is to find a generator \(G^*\) that can make minimize the divergence between \(P_G\) and \(P_{data}\). However, the divergence (e.g., KL or JS) is hard to compute when the distribution is continuous.

Although we do not know how to formulate the continuous distributions \(P_G\) and \(P_{data}\), we can sample from them.

When it needs to be maximized, it is called an objective function; conversely, it is called a loss function.

Training Discriminator: \(D^* = \arg \max\limits_D V(D, G)\) and objective function for discriminator \(D\): \(V(D, G) = E_{y \sim P_{data}}[\log D(y)] + E_{y \sim P_G}[\log (1-D(y))]\) (\(\sim\) represents the random variable \(y\) follows the distribution, 遵循/服从于)。因为要最大化 \(V\) 的值(最大化 discriminator 区分真假样本的能力),所以希望如果样本是从真实数据中采样的,discriminator 给出的分数越高越好。如果是从 generator 生成的样本中采样的,则分数越小越好。\(V(D, G)\) is equal to negative cross entropy, so training discriminator is equal to train classifier, and the maximum objective value \(\max\limits_D V(D, G)\) is related to JS divergence (if the two distributions are similar, data sampled from them is mixed, so it’s hard to discriminate and \(\max\limits_D V(D, G)\) is small). So we can replace the old objective function \(Div(P_G, P_{data})\) with the new one \(\max\limits_D V(D, G)\), i.e.,

\[G^* = \arg \min\limits_G \max\limits_D V(D, G)\]即在给定 generator 的条件下找 discriminator 来 maximize \(V(D, G)\),然后再找 generator 来 minimize \(\max\limits_D V(D, G)\),具体用 Algorithm 部分的步骤来解。

Tips for GAN

Manifold(流形):是一个局部具有欧几里得空间(平直空间)性质的高维空间(复杂空间),即存在于高维空间的数据其实可以用潜在的低维流形来表示,或者说在高维空间中实际有效的数据点(即反映数据本质结构和关系的点)可能只占据了一小部分区域,或者说高维空间中的所有点并非都同等重要。流形学习就是学习一种“将数据从高维空间降维到低维空间,还能不损失信息”的映射,从而能够揭示数据的内在结构(非线性 ok),帮助我们更好地表示和理解数据。

-

JS divergence is not suitable, because \(P_G\) and \(P_{data}\) are not overlapped

Explanation 1: The nature of data, i.e., both are low-dim manifold in high-dim space, so the overlap can be ignored;

Explanation 2: Even though they have overlap, if sampling is not sufficient, there is always a boundary that can separate them.

Problem: JS divergence is always log2, so even though the distances between two distributions are different, they are same to the JS divergence, which results in the inability to update parameters during training. In this case, binary classifier always achieves 100% accuracy.

-

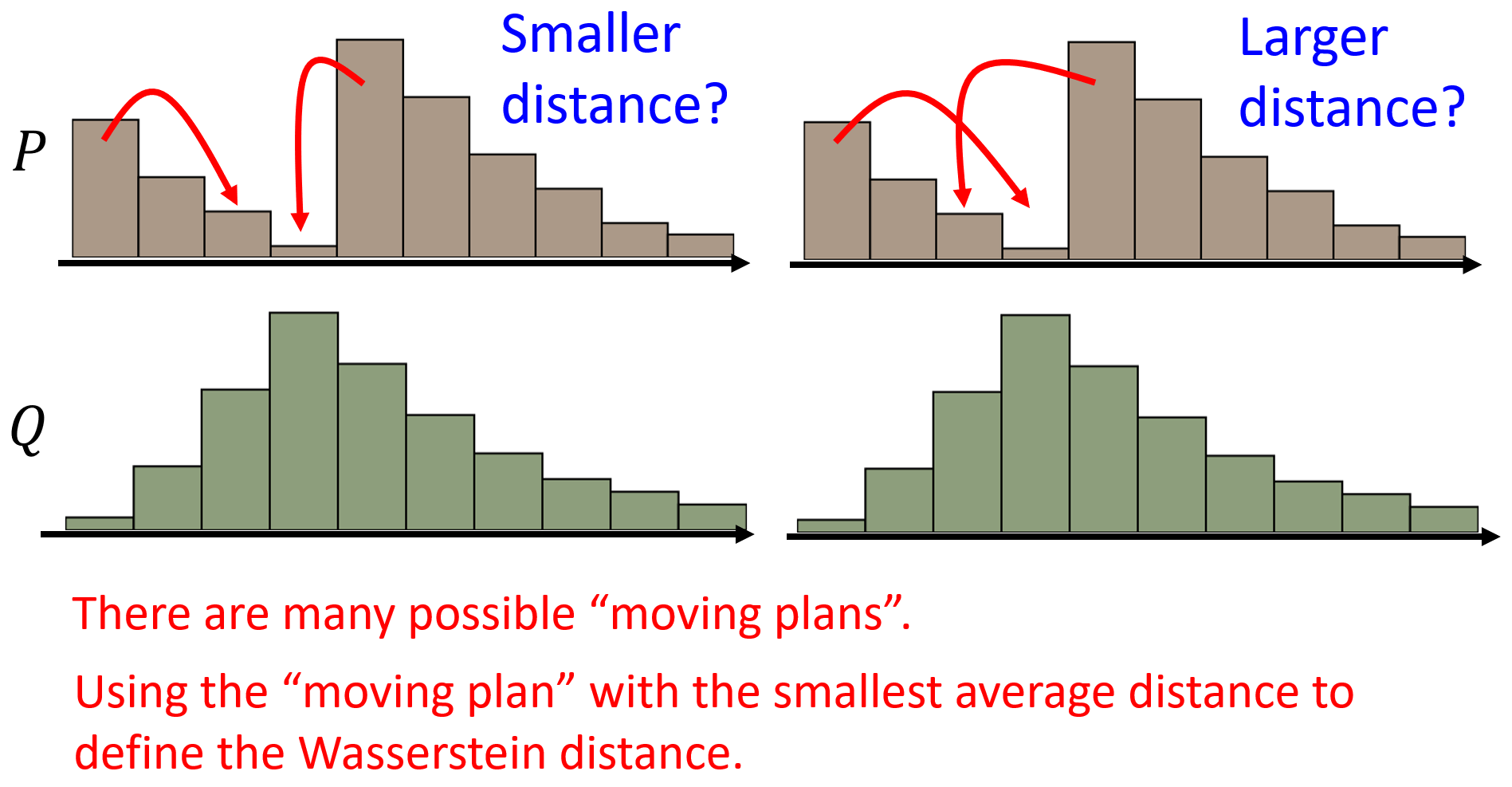

WGAN

用 Wasserstein distance 替代 JS divergence。Wasserstein distance (Earth Mover’s Distance, EMD) 是指衡量将一个概率分布变换成另一个概率分布所需的最小“成本”或“工作量”。所以如果两个分布没有重叠,当它们之间的距离不同时,Wasserstein distance 也能给出相应不同的值,从而能够进行 optimization,而非像 JS divergence 那样始终是常数。

Lipschitz Continuity:一个函数 \(f: X \rightarrow Y\),存在一个实数 \(c\),对于该函数定义域 \(X\) 上的任意两点 \(x_1, x_2\),连接它们的直线的斜率的绝对值不大于这个实数,即 \(\frac{\vert f(x_1) - f(x_2) \vert}{\vert x_1 - x_2 \vert} \le c\)。它本质上是限制了连续函数斜率的变化,保证了函数的平滑性。1-Lipschitz 即实数 \(c\) 的值为 1。

Spectral Normalization:是一种正则化技术,用于约束神经网络中权重矩阵的谱范数(spectral norm),可以控制该层输出相对于输入变化的速度,从而确保神经网络满足 Lipschitz 连续性。Spectral norm 是矩阵的最大奇异值,可以理解为矩阵的最大“拉伸因子”。具体步骤为:1)对于每个权重矩阵 \(W\),计算其最大奇异值 \(\sigma(W)\);2)对 \(W\) 进行归一化,即新的权重矩阵为 \(W/\sigma(W)\)。其优势在于不需要额外的超参数调整。

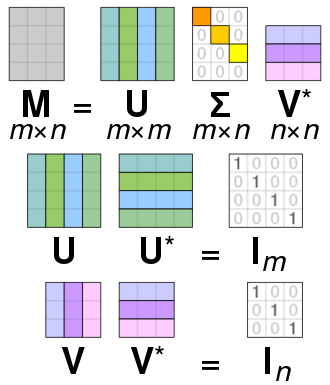

Singular Value Decomposition (SVD,奇异值分解):给定一个矩阵 \(M\),有 \(M = U \Sigma V^T\)。其中,\(U\) 和 \(V\) 是 Orthogonal Matrix(如果一个矩阵是正交矩阵,则它和它 transpose 的乘积是 Identity Matrix),\(\Sigma\) 是 Diagonal Matrix,对角线上的元素是 \(M\) 的奇异值,并且这些奇异值是按照从大到小的顺序排列的。

WGAN 的 optimization 为:

\[D^* = \arg \max\limits_{D \in 1-Lipschitz} \{E_{y \sim P_{data}}[D(y)] - E_{y \sim P_G}[D(y)]\}\]其中的目标函数的值就当作是 Wasserstein distance。因为目标是前一个 \(D(y)\) 要越大越好,后一个则越小越好。所以如果没有 1-Lipschitz 的限制,当真实样本和生成样本没有重叠的时候,discriminator 会分别给出 \(\infty\) 和 \(-\infty\) 的分数,从而导致 discriminator 的训练无法收敛。并且只要是没有重叠,不论分布之间的距离大小,最后得到的值都会是 \(\infty\),这就跟 JS 散度一样了。加上 1-Lipschitz 限制后,因为要求 discriminator 足够平滑,所以当分布之间距离小时,Wasserstein distance 值就会比较小,反之就会比较大,从而保证了训练的稳定性。

WGAN 并没有真正地实现 1-Lipschitz,实际操作上可以用 Spectral Normalization (Keep gradient norm smaller than 1 everywhere) 来实现 1-Lipschitz,也就是 SNGAN。

-

GAN for Sequence Generation

Gradient 其实是当某一个参数有变化时,对目标造成了多大的影响。当 generator 的参数有一个小变化时,它输出的 distribution 也会有一个小变化,但是这不会影响它最终输出的 token 是哪一个(因为取的是 max),所以 discriminator 输出的分数也不会改变。因此,Gradient descent is not work。

-

Diversity of GAN

Problem 1: Mode Collapse. 生成器开始生成几乎相同的样本,而无法覆盖到真实数据分布的多样性。

Problem 2: Mode Dropping. 生成器遗漏了一部分真实数据的分布。

检测 diversity 的方法:将 generator 的输出 \(y^i\) 输入到一个 classifier 里面,每个 \(y^i\) 都会得到一个分布 \(P(c \mid y^i)\),将所有的分布取平均,如果平均的分布非常集中(比如都属于某一类),则说明多样性不够。值得注意的是,diversity 是以多个生成器的输出(e.g., 1000 images)来评价的,而 quality 是以单个输出(e.g., 1 image)来评价的。

通过 classifier 的输出的类别可能都是一样的,比如生成的分子不同,但是类别都是化合物;或者生成的人脸不同,但类别都是人脸。所以要用 softmax 之前的 hidden layer 的输出向量,这个向量是不同的,用真实数据和生成数据的这个向量来计算 Frechet Inception Distance,这个值越小多样性越高。

Problem 3: 如何评判 generator 生成的样本是不是 GAN 所 memory 的?Evaluation of GAN is difficult.

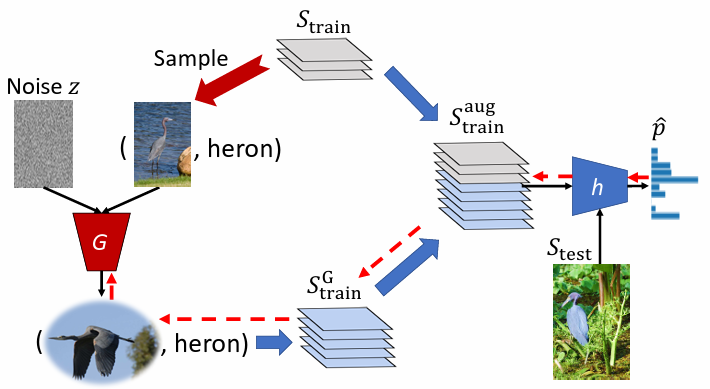

Conditional Generation

加回 \(\boldsymbol{x}\) ,作为 condition,用来操控 generator 的输出。例如,Text-to-image 的任务,\(\boldsymbol{x}\) 就是一段文字,通过 RNN 或 Transformer’s Encoder 等等将其编码为向量再输入到 generator 里。

按照 Unconditional 的训练方法 generator 只需要学习到如何生成真实的数据即可“骗过” discriminator(因为 discriminator 的输入只有 generator 的输出 \(\boldsymbol{y}\)),并没有学习到所输入的 condition \(\boldsymbol{x}\)。现在 discriminator 的输入还要包括 \(\boldsymbol{x}\),所以 discriminator 的评判标准变为 \(\boldsymbol{y}\) is realistic or not + \(\boldsymbol{x}\) and \(\boldsymbol{y}\) are matched or not。因此,需要成对的输入数据(\(\boldsymbol{x}\), \(\boldsymbol{y}\) pairs)来训练,实际上,需要给 discriminator 的是完全配对时是 1,\(\boldsymbol{y}\) 不够好的时候是 0,还有 \(\boldsymbol{y}\) 足够好但是和 \(\boldsymbol{x}\) 不匹配也是 0。所以喂给 discriminator 的 pairs 中应该有正确配对的,也应该有错误配对的。

Conditional GAN + Supervised Learning 可以让 generator “骗过” discriminator,同时也让生成的结果最接近“标准答案”(即 condition \(\boldsymbol{x}\)),例如 pix2pix(按照草稿给出房屋设计图)。特别适用于生成的数据和 condition 的模态一致的情况。

If training data is unpaired, network needs to learn to how to output domain \(Y\) from input domain \(X\) (e.g., Style Transfer). Similarly, the generator can ignore the input data, but also fools the discriminator. And because the input data is unpaired, so conditional GAN is not work.

Add another generator \(G_{Y \rightarrow X}\) after the first generator \(G_{X \rightarrow Y}\), \(G_{Y \rightarrow X}\) is to reconstruct the the output of \(G_{X \rightarrow Y}\) from domain \(Y\) back to domain \(X\). And we hope that the output of \(G_{Y \rightarrow X}\) and the input of \(G_{X \rightarrow Y}\) are as close as possible, the similarity between them can be considered as equivalent to the distance between two vectors. There is also a discriminator that outputs a scalar to determine whether the output of \(G_{X \rightarrow Y}\) belongs to domain \(Y\) or not.

The process mentioned above can also be reversed. So Cycle GAN is bidirectional.

VAE

Auto-Encoder 的流程:

Input data (high-dims) \(\longrightarrow\) Encoder \(\xrightarrow[]{\text{Compression}}\) vector (low-dims) \(\longrightarrow\) Decoder \(\xrightarrow[]{\text{Reconstruction}}\) Output data (as close to the input data as possible)

设 Auto-Encoder 的 Encoder 输出的 vector 是 original vector,对于 VAE (Variational Auto-Encoder) 来说,Encoder 输出的是两个 vector \([m_1, m_2, \dots, m_N]\) 和 \([\sigma_1, \sigma_2, \dots, \sigma_N]\)(维度和 original vector 一致),然后从一个 normal distribution 中采样一个 vector \([e_1, e_2, \dots, e_N]\),通过 \(c_i = \text{exp}(\sigma_i) \times e_i + m_i\) 得到 vector \([c_1, c_2, \dots, c_N]\),这个 vector 是用于输入到 Decoder 中的。并且,训练的过程中不仅要让 output data 和 input data 越接近越好,还需要最小化 \(\sum_{i=1}^N(\text{exp}(\sigma_i) - (1 + \sigma_i) + (m_i)^2)\)。

这里的 \([m_1, m_2, \dots, m_N]\) 代表了 original vector,\([\sigma_1, \sigma_2, \dots, \sigma_N]\) 代表了 noise 的 variance,从而决定了 noise 的大小(因为 \([e_1, e_2, \dots, e_N]\) 的 variance 是固定的),取 exponential 保证 variance 一定是正的。因此,\([c_1, c_2, \dots, c_N]\) 相当于 original vector with noise。这个 variance 的大小应该是多少是机器在训练时自己学出来的,但是如果不加限制,variance 一定会倾向于为 0,因此给它一个限制让 variance 不能太小 \(\sum_{i=1}^N(\text{exp}(\sigma_i) - (1 + \sigma_i) + (m_i)^2)\),式中 \(\text{exp}(\sigma_i) - (1 + \sigma_i)\) 的最低点为 \(\sigma_i = 0\) 时,所以 \(\text{exp}(\sigma_i)\) 的 variance 最小值为 1。\((m_i)^2\) 这一项则相当于做 L2 regularization。

我们想要的是 estimate the probability distribution

Multinomial Distribution:用于描述在具有多个可能结果的实验中,每个结果出现次数的概率,属于一种离散概率分布。其 PMF (Probability Mass Function) 为 \(P(X_1 = x_1, X_2 = x_2, \dots, X_k = x_k) = \frac{n!}{x_1! x_2! \cdots x_k!} p_1^{x_1} p_2^{x_2} \cdots p_k^{x_k}\),并且有 \(\sum^k_{i=1}p_i=1\),\(\sum^k_{i=1}x_i=n\)。

Gaussian Mixture Model:由若干个高斯分布组成,每个高斯分布在混合中都有自己的比重,每个数据点都被看作是由这些高斯分布中的一个生成的。其公式为 \(P(x) = \sum_m P(m)P(x \mid m)\),\(m \sim P(m)\) 表示从一个 multinomial distribution 中采样出第 \(m\) 个高斯分布,\(x\) 是从 \(m\) 中采样得到的,即 \(x \mid m \sim N(\mu^m, \sigma^m)\)。

Maximum Likelihood Estimation:用于从一组给定的数据中估计模型的参数,核心思想是选择可以使观测到的数据出现概率(即似然)最大的参数值作为最佳估计。首先,假设有数据集 \(D\),包含 \(n\) 个独立同分布的观测数据点 \(\{x_1, x_2, \dots, x_n\}\) 和模型参数 \(\theta\)。定义似然函数 \(L(\theta)\) 为在参数 \(\theta\) 下观察到数据集 \(D\) 的概率 \(L(\theta) = P(D \mid \theta) = \prod^n_{i=1} P(x_i \mid \theta)\)。然后取对数将乘积转换为求和 \(\log L(\theta) = \sum^n_{i=1} \log P(x_i \mid \theta)\),然后对对数似然函数求导并令其为 0 \(\frac{d}{d\theta} \log L(\theta) = 0\),即可求出使对数似然函数最大化的参数值。

\(P(z,x) = P(z \mid x)P(x)\),\(P(z,x)\) 是 \(z\) 和 \(x\) 同时发生的联合概率。

上述是 VAE 的直观解释,数学解释如下:

基于 Gaussian Mixture Model 的原理,首先从 normal distribution 中 sample 出一个 vector \(z\)。\(z\) 的每一个维度代表了一个属性(attribute)。从 \(z\) 中采样可以对应到不同的 normal distribution,所以由 \(z\) 可以决定 normal distribution \(P(x \mid z)\) 的 mean 和 variance,即 \(\mu(z)\) 和 \(\sigma(z)\),写作 \(x \mid z \sim N(\mu(z), \sigma(z))\)。由于 \(z\) 是 continuous 的,所以 \(\mu(z)\) 和 \(\sigma(z)\) 有无限多的可能,可以用 NN 来学(\(z\) 为输入,\(\mu(z)\) 和 \(\sigma(z)\) 为输出)。从而得到 \(P(x) = \int\limits_{z}P(z)P(x \mid z)dz\),\(P(z)\) 也是一个 normal distribution。这里要解决的是 \(\mu(z)\) 和 \(\sigma(z)\) 需要被估计,它的 criterion 是 maximize the likelihood \(L = \sum\limits_x \log P(x)\) of the observed \(x\),即需要调整 NN 的参数使得 \(L\) 最大。另外,还需要一个分布 \(Q(z \mid x)\) with \(z \mid x \sim N(\mu'(x), \sigma'(x))\) 来决定 \(P(z)\) 的 mean 和 variance,即 \(\mu'(x)\) 和 \(\sigma'(x)\)。所以需要另一个 NN’,输入 \(x\) 输出 \(\mu'(x)\) 和 \(\sigma'(x)\)。因此,NN(\(P(x \mid z)\))就相当于 VAE 的 Decoder,NN’(\(Q(z \mid x)\))就相当于 VAE 的 Encoder。

针对 criterion 进行推导:

对于 lower bound \(L_b = \int\limits_z Q(z \mid x) \log (\frac{P(x \mid z)P(z)}{Q(z \mid x)})dz\),未知的是 \(P(x \mid z)\) 和 \(Q(z \mid x)\)。原本依据 \(P(x) = \int\limits_{z}P(z)P(x \mid z)dz\) 我们只需要找 \(P(x \mid z)\) 来最大化 likelihood,现在则需要找 \(P(x \mid z)\) 和 \(Q(z \mid x)\) 来最大化 \(L_b\)。如果还是只找 \(P(x \mid z)\) 来最大化 \(L_b\),则有可能 \(L_b\) 增加但 likelihood 反而减小,因为不知道它们之间的差距是多少,likelihood 减小也会比 \(L_b\) 大。因为 \(\log P(x)\) 的大小与 \(Q(z \mid x)\) 无关,所以如果先固定住 \(P(x \mid z)\)(即 \(\log P(x)\) 的大小保持不变)再调 \(Q(z \mid x)\) 去最大化 \(L_b\),就可以让 \(L_b\) 越来越接近 likelihood(\(\log P(x)\))。等到两者相等时,再增大 \(L_b\) 就可以保证 likelihood 一定也是增大的(因为 \(\log P(x) \ge L_b\))。但是总归来说 VAE 直接优化的是 \(L_b\),而不是 likelihood,所以这两者之间具体的差距到底是多少我们并不清楚,这也是 VAE 的局限性。

\[\begin{align*} L_b &= \int\limits_z Q(z \mid x) \log (\frac{P(x \mid z)P(z)}{Q(z \mid x)})dz \\ &= \int\limits_z Q(z \mid x) \log (\frac{P(z)}{Q(z \mid x)})dz + \int\limits_z Q(z \mid x) \log P(x \mid z)dz \\ &= -KL(Q(z \mid x) \parallel P(z)) + \int\limits_z Q(z \mid x) \log P(x \mid z)dz \end{align*}\]对于 \(L_b\) 的第一项 \(-KL(Q(z \mid x) \parallel P(z))\),最小化的方法是调 \(Q(z \mid x)\) 所对应的 NN’ 的参数让它产生的 distribution 和一个 normal distribution 越接近越好。最小化第一项,其实就是最小化 \(\sum_{i=1}^N(\text{exp}(\sigma_i) - (1 + \sigma_i) + (m_i)^2)\)。

对于 \(L_b\) 的第二项 \(\int\limits_z Q(z \mid x) \log P(x \mid z)dz\),可以想成是用 \(Q(z \mid x)\) 对 \(\log P(x \mid z)\) 做 weighted sum,所以就可以看作是一个期望值 \(\int\limits_z Q(z \mid x) \log P(x \mid z)dz = E_{Q(z \mid x)}[\log P(x \mid z)]\)。相当于向 NN’ 输入一个 \(x\),从 NN’ 输出的一个 distribution(\(Q(z \mid x)\))中可以采样出一个 \(z\),然后需要最大化由这个 \(z\) 再产生 \(x\) 的概率(\(\log P(x \mid z)\)),要做到最大化需要将 \(z\) 输入到 NN 中,NN 会输出 \(\mu(x)\) 和 \(\sigma(x)\),希望 \(\mu(x)\) 和 \(x\) 越接近越好(在 normal distribution 中 \(\mu(x)\) 这个点的概率是最高的)。

因此,\(L_b\) 就是 VAE 的 loss function。

VAE 的问题:VAE 可能只是会模仿,而没有办法创新。

Flow-based Model

Flow-based model can directly optimize the objective function \(G^* = \arg \max\limits_G \sum^n_{i=1} \log P_G(x^i)\), i.e., maximizing the likelihood, instead of indirectly minimizing the divergence \(G^* = \arg \min\limits_G \text{Div}(P_G, P_{data})\).

Jacobian Matrix:如果有一个函数 \(\boldsymbol{x} = f(\boldsymbol{z})\),其中向量 \(\boldsymbol{x}\) 是关于向量 \(\boldsymbol{z}\) 的函数,Jacobian Matrix 可以表示为 \(\boldsymbol{x}\) 关于 \(\boldsymbol{z}\) 的所有一阶偏导数。如果 \(\boldsymbol{x}\) 由 \(m\) 个分量组成,\(\boldsymbol{z}\) 由 \(n\) 个分量组成,则 Jacobian Matrix \(\boldsymbol{J}\) 为:

\[\boldsymbol{J}_f = \begin{bmatrix} \frac{\partial x_1}{\partial z_1} & \frac{\partial x_1}{\partial z_2} & \cdots & \frac{\partial x_1}{\partial z_n} \\ \frac{\partial x_2}{\partial z_1} & \frac{\partial x_2}{\partial z_2} & \cdots & \frac{\partial x_2}{\partial z_n} \\ \vdots & \vdots & \ddots & \vdots \\ \frac{\partial x_m}{\partial z_1} & \frac{\partial x_m}{\partial z_2} & \cdots & \frac{\partial x_m}{\partial z_n} \end{bmatrix}\]可以把 \(f\) 当作 generator,\(\boldsymbol{z}\) 当作 input,\(\boldsymbol{x}\) 当作 output (generation)。

如果有一个 \(f\) 的反函数 \(\boldsymbol{z} = f^{-1}(\boldsymbol{x})\),其 Jacobian Matrix \(\boldsymbol{J}_{f^{-1}}\) 与 \(\boldsymbol{J}_f\) 相乘的结果为单位矩阵,即 \(\boldsymbol{J}_f \boldsymbol{J}_{f^{-1}} = I\)。

Determinant:The determinant of a square matrix is a scalar that provides information about the matrix. 因为有 \(\det(A) \cdot \det(A^{-1}) = 1\),所以有 \(\det(\boldsymbol{J}_f) \cdot \det(\boldsymbol{J}_{f^{-1}}) = 1\)。二阶行列式的几何意义是二维空间中平行四边形的面积,三阶行列式的几何意义是三维空间中平行六面体的体积,更高阶行列式的几何意义是高维空间中的“体积”。另外,一个矩阵做 transpose 不会改变它的 determinant,即 \(\det(A) = \det(A^T)\)。

Change of Variable Theorem:假设有一个分布 \({\pi(\boldsymbol{z})}\)(相当于 generator 输入的分布)和一个函数 \(\boldsymbol{x} = f(\boldsymbol{z})\),\(\boldsymbol{x}\) 也形成一个分布为 \(p(\boldsymbol{x})\)(相当于 generator 输出的分布),在分布 \({\pi(\boldsymbol{z})}\) 上有一点 \(z'\),它的 probability density value 是 \(\pi(z')\),\(z'\) 通过函数后会得到 \(x'\),它的 probability density value 是 \(p(x')\)。\(\pi(z')\) 与 \(p(x')\) 之间存在关系:\(p(x')\vert\det(\boldsymbol{J}_f)\vert = \pi(z')\) 等同于 \(p(x') = \pi(z')\vert\det(\boldsymbol{J}_{f^{-1}})\vert\)。

由 Change of Variable Theorem,可以将 \(G^* = \arg \max\limits_G \sum^n_{i=1} \log p_G(x^i)\) 中的 \(\log p_G(x^i)\) 表示出来,即 \(p_G(x^i) = \pi(z^i)\vert\det(\boldsymbol{J}_{G^{-1}})\vert\) 和 \(z^i = G^{-1}(x^i)\),进一步推导有 \(\log p_G(x^i) = \log \pi(G^{-1}(x^i)) + \log \vert\det(\boldsymbol{J}_{G^{-1}})\vert\)。但是算 \(\log p_G(x^i)\) 的这个式子要有两个前提,一是需要计算 \(\boldsymbol{J}_{G^{-1}}\),即计算 \(\boldsymbol{J}_G\),尽管只需要知道怎么计算 \(\frac{\partial{x_i}}{\partial{z_i}}\) 即可,但是 \(\boldsymbol{J}_G\) 可能会很大,导致计算 \(\det(\boldsymbol{J}_G)\) 的运算量非常大。二是 \(G^{-1}\) 是可被计算的,所以要求 \(G\) 必须是 invertible 的,则输入 \(\boldsymbol{z}\) 的维度和输出 \(\boldsymbol{x}\) 的维度就需要保持一致。因此,Flow-based Model 的 \(G\) 具有一定的限制性。

既然如此,那就将多个 \(G\) 依次连接起来(所以叫 Flow),对于 \(\{G_1, \dots, G_N\}\),有 \(p_K(x^i) = \pi(z^i)(\vert\det(\boldsymbol{J}_{G^{-1}_1})\vert) \cdots (\vert\det(\boldsymbol{J}_{G^{-1}_N})\vert)\),

所以有 \(\log p_N(x^i) = \log \pi(z^i) + \sum\limits^N_{n=1} \log \vert\det(\boldsymbol{J}_{G^{-1}_N})\vert\) 和 \(z^i = G^{-1}_1(\cdots G^{-1}_N(x^i))\)。

虽然用于生成的是 \(G\),但实际训练的是 \(G^{-1}\),即从 \(p_{data}(x)\) 中采样 \(x^i\),然后输入进 \(G^{-1}\) 得到 \(z^i = G^{-1}(x^i)\)。对于 \(\log p_G(x^i) = \log \pi(G^{-1}(x^i)) + \log \vert\det(\boldsymbol{J}_{G^{-1}})\vert\) 的第一项 \(\log \pi(z^i)\),因为 \(\pi\) 是一个 normal distribution,所以 \(z^i\) 为 zero vector 时,\(\pi(z^i)\) 最大。但是如果经过训练后 \(z^i\) 都是 zero vector,会导致 \(\boldsymbol{J}_{G^{-1}}\) 为 zero matrix,\(\det(\boldsymbol{J}_{G^{-1}}) = 0\),则第二项会趋近于 \(-\infty\),从而导致无法最大化 \(\log p_G(x^i)\)。所以最大化时要同时考虑这两项,第一项让 \(z^i\) 趋近于 zero vector,第二项限制不会让所有的 \(z^i\) 都变为 zero vector。

Flow-based model 中常用的 \(G\) 是 Coupling Layer,它被用于 RealNVP 和 Glow 中。Coupling Layer 的核心思想是将输入分割成两部分,然后以一种方式修改其中一部分,并且这种修改依赖于另一部分的值,同时保持另一部分不变。Coupling Layer 允许进行复杂的变换,同时可以保持整个变换过程的可逆性。

对于一个 \(D\) 维的输入向量 \(z_D\),将其分成两部分 \((z_1, \dots, z_d)\) 和 \((z_{d+1}, \dots, z_D)\),前一部分保持不变输出 \((x_1, \dots, x_d)\),并且前一部分分别通过函数 \(F\) 和函数 \(H\) 得到 \((\beta_{d+1}, \dots, \beta_D)\) 和 \((\gamma_{d+1}, \dots, \gamma_D)\)(\(F\) 和 \(H\) 是任意的),然后通过 \(x_{i > d} = \beta_{i > d} \cdot z_{i > d} + \gamma_{i > d}\) 计算得到 \((x_{d+1}, \dots, x_D)\)。可逆性体现在,当我们知道 \((x_1, \dots, x_d)\) 和 \((x_{d+1}, \dots, x_D)\) 时,对于前者,由于不变可以直接通过 \(z_{i \le d} = x_{i \le d}\) 得到 \((z_1, \dots, z_d)\)。然后将其正向通过 \(F\) 和 \(H\) 可以分别得到 \((\beta_{d+1}, \dots, \beta_D)\) 和 \((\gamma_{d+1}, \dots, \gamma_D)\),就可以根据公式 \(z_{i > d} = \frac{x_{i>d} - \gamma_{i>d}}{\beta_{i>d}}\) 得到 \((z_{d+1}, \dots, z_D)\)。因此,依据可逆性就可以算出 \(z^i\)。

对于 \(\det(\boldsymbol{J}_G)\) 的计算,具体看视频 Timestamp - 49:28,最后公式为 \(\det(\boldsymbol{J}_G) = \beta_{d+1}\beta_{d+2} \cdots \beta_D\),因此也很容易计算。

在对 Coupling Layer 进行堆叠(stack)时,需要在某些位置换一下不变的那一部分的位置,可以防止最初设定的不变的那一部分最后的输出还是和输入(随机采样的 noise)一样。

在 GLOW 中还用了一种方法 1x1 Convolution,给定一个 3x3 的 Matrix \(W\)(3 channels)作为 \(G\),通过学习这个 \(W\) 做到 shuffle the channels。\(W\) 也需要是 invertible 的。

Diffusion Model

生成分子的多样性:VAE、FLOW-based Model

生成分子的质量和细节:GAN、Diffusion Model

7. Self-Supervised Learning

Self-Supervised Learning 是通过利用输入的无标记数据本身的结构来生成标签(一部分数据作为输入,另一部分则作为这个输入的预期输出或标签),进而训练模型,从而无需依赖外部的、成本高昂的标注过程。这种学习方法允许模型通过预测任务来自我学习,从而提取和理解数据的内在结构和特征。

BERT (Encoder-Only)

BERT (Bidirectional Encoder Representations from Transformers) is an Encoder.

Masking Input

Randomly masking some tokens, with the method of masking also chosen randomly: there’re 2 methods, one is to use a special token (e.g., [MASK]), and the other is to use another random token.

然后将 masked token 通过 BERT,其输出做一个 Linear 的 transform 和 softmax 后得到一个分布,再将这个分布与 ground truth 计算 cross-entropy。训练 BERT 使其能够成功预测 masked token 是什么(填空题),相当于一个分类问题。

Masking Input 任务就是一个自监督学习的过程,这个过程不需要外部的标签,因为正确的标签(即被 masked 之前的 token)已经包含在输入中。

Next Sentence Prediction

Add a [CLS] token at the beginning, and add a [SEP] token between two sentences. BERT 处理整个序列,为序列中的每个 token 输出一个向量,但是只有 [CLS] 的向量随后被输入到一个线性层中(这个向量能够捕获整个输入序列的上下文信息(Self-attention)/ 看过整个 sentence 了),根据最终输出的 class 来预测第二个句子是否为第一个句子的逻辑后续。

But NSP is maybe not useful. 所以有以下几种改进:

Fine-tune

BERT 可以通过 fine-tune(need a little bit labeled data)后用于各种 downstream tasks,相当于干细胞。在 fine-tune 中,向模型中输入少量有标记的数据,模型的所有参数(包括 BERT 的原始参数和线性层的新参数)通常都会根据特定任务的损失函数进行优化,以最小化预测输出和实际标签之间的差异,从而提高模型在该任务上的表现。

Pre-train

在 fine-tune 之前产生 BERT 的过程是 Self-Supervised Learning,也叫做 Pre-train。

The use of BERT: Pre-train + Fine-tune can be considered as Semi-supervised Learning (i.e., A large amount of unlabeled data and a small amount of labeled data).

Case 1: Input is sequence, output is class. Add a [CLS] token before the sequence, BERT outputs a vector for each token fed into it, but only the output vector of [CLS] will be input into Linear, and finally output the class. BERT and Linear both need to update parameters, the parameters of Linear is random initialization, but BERT is initiated by Pre-train.

Case 2: Input is sequence, output is also sequence, and both have the same length. BERT outputs a vector for each token fed into it, each vector will be input into Linear, and get its output class.

Case 3: Input is two sequences, output is class. Add a [CLS] token at the beginning, and add a [SEP] token between two sequences. The rest as in case 1.

Case 4: QA。对 BERT 输入一个 sequence,得到 sequence 中每个 token 对应的输出向量 $\boldsymbol{t^i}$,随机初始化一个向量 \(\boldsymbol{v}\),将这两者做 Self-attention 后通过 softmax 输出每个 token 对应的概率,最后输出概率最高的 token。也可以初始化两个向量,可以输出由两个 token 组成的这个 sequence 的范围。上述基于正确答案一定在输入的 sequence 里面。

In general,最常见的用法是:BERT 是预训练好的,后面接一个 Linear Classifier,再通过少量的有标记的数据微调两者的参数即可。

BERT 只是 Pre-train 了一个 Encoder,那么如何 Pre-train 一个 seq2seq model 呢?需要将 input sequence 弄坏(corrupted),然后希望 Decoder 输出的 sequence 和弄坏前一模一样(Encoder 和 Decoder 由 cross attention 连接)。弄坏的方法:Mask token、Delete token、打乱顺序、或 Mask + 打乱等等。BART

Cosine Similarity:对于 n 维向量 \(\boldsymbol{A}\) 和 \(\boldsymbol{B}\),它们的余弦相似度为

\[\text{cosine similarity} = \cos(\theta) = \frac{\boldsymbol{A} \cdot \boldsymbol{B}}{\Vert \boldsymbol{A} \Vert \Vert \boldsymbol{B} \Vert} = \frac{\sum\limits_{i=1}^{n} A_i B_i}{\sqrt{\sum\limits_{i=1}^{n} A_i^2} \sqrt{\sum\limits_{i=1}^{n} B_i^2}}\]余弦相似度可以很好地衡量两个向量方向的一致性,而忽略它们的大小。

Sequence 的 token 经过 BERT 处理后输出的向量可以称之为 embedding。同样的 token 在不同的上下文中可能代表的意思就不同,所以它们的 embedding 也会不同,计算 embedding 之间的余弦相似度可以用于判断其相似性。BERT 在学习做填空题的过程中(Masking input)也许就是学习从上下文(context)中获取信息来进行预测,由于这里的 embedding 是考虑了上下文信息的,所以可以称之为 contextual embedding。

GPT (Decoder-Only)

GPT (Generative Pre-trained Transformer) 的任务是预测下一个出现的 token 是什么,所以 GPT 具有生成的能力。首先输入 <BOS> token,GPT 输出相应的 embedding,embedding 会通过 Linear Transform 输出一个分布,然后优化其与真实分布之间的交叉熵,以此类推。相当于 Transformer 的 Decoder,只不过 GPT 是经过预训练的且没有 Cross Attention 那部分,只有 Masked Self-attention 那部分。

Prompt:指输入给模型的文本片段,模型据此生成相应的输出,即 Prompt 用于指导模型的生成。

The use of GPT in downstream tasks: Description, example, and prompt.

GPT 基于大规模的预训练和理解上下文的能力,能够在仅有少量所提供的样本的情况下快速适应新的任务,并生成与这些样本相似的输出。这使得 GPT 在很多情况下能够实现或接近专门针对特定任务进行微调的效果。

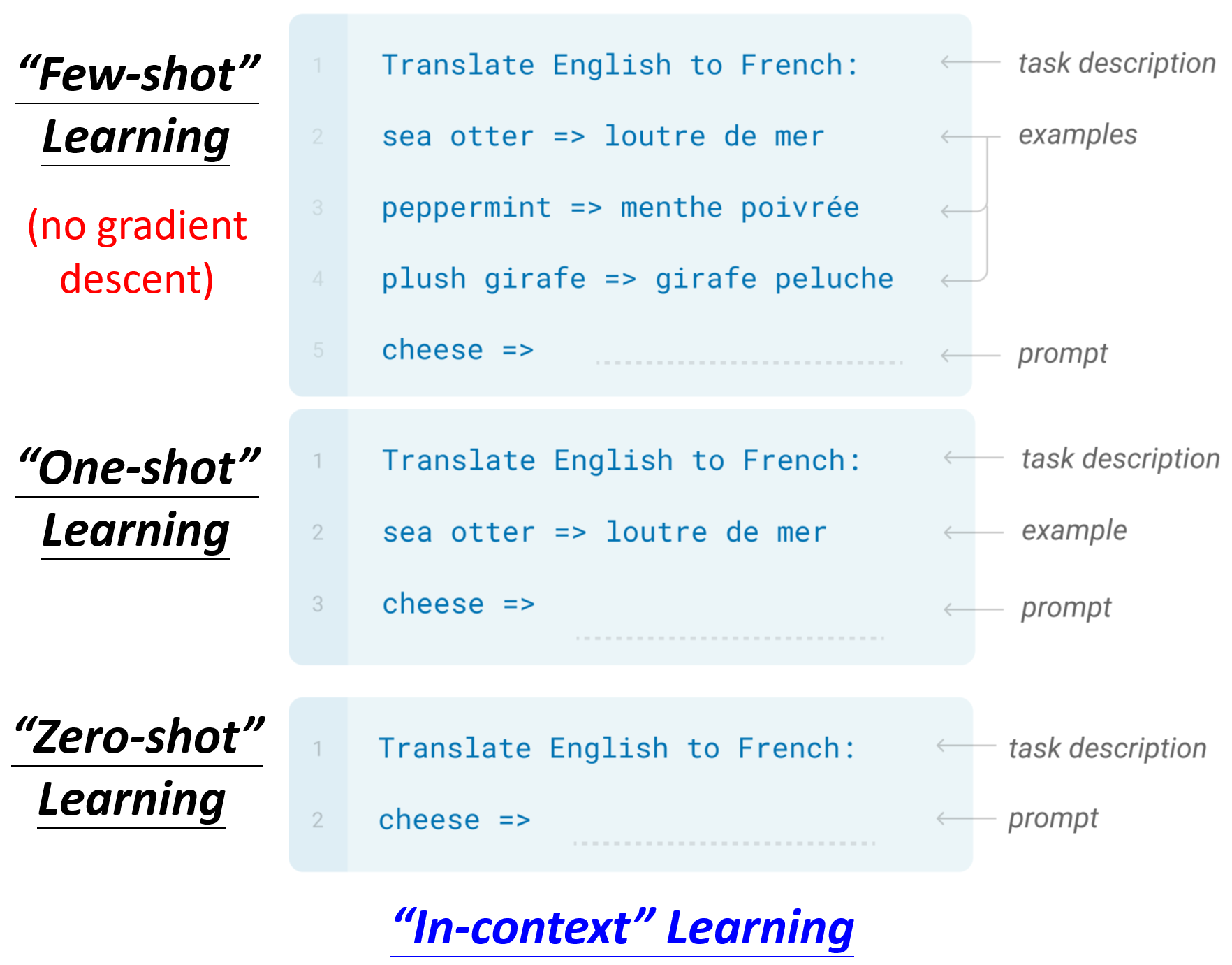

在 GPT 中的 Few-shot / One-shot / Zero-shot Learning,和一般的不一样,这里并没有做 gradient descent,也就没有微调 GPT 的参数。所以在文献中称作 In-context Learning。

Auto-encoder

Input data (high-dims) \(\longrightarrow\) Encoder \(\xrightarrow[]{\text{Compression}}\) vector (low-dims) \(\longrightarrow\) Decoder \(\xrightarrow[]{\text{Reconstruction}}\) Output data (as close to the input data as possible)

Here, vector can be called embedding, representation or feature. And this vector is usually used for downstream tasks.

Auto-encoder 中间输出低维向量的层又被称作 Bottleneck,Bottleneck 强制 Auto-encoder 在有限的维度中捕获输入数据的最重要特征,以便在 Decoder 中尽可能准确地重建输入。因此,Auto-encoder也可以用来做 Dimension Reduction。

虽然输入数据的维度很高,从表面上看比较复杂,但是实际的变化可能是有限的,所以可以用更简单的方法来表示它。那么在下游的任务中,可能只需要比较少的训练数据就可以让模型学到本来应该学到的东西。

De-noising Auto-encoder

给原本的输入加上 noise 作为 Encoder 新的输入,但是 Decoder 重建的还是没有 noise 的输入。BERT 的 Mask Input 其实也相当于是加上 noise。

Feature Disentanglement 的目的是尝试搞清楚 encoder 输出的 embedding 中,各个/些维度分别代表了什么实际的含义。

Discrete Latent Representation

原本 encoder 输出的 embedding 中的值是 continuous 的,现在使用离散值来表示隐含的特征或状态,每个隐含状态可以对应到一组有限的标签或类别上,从而使得模型可以更简洁地捕捉到关键的信息。比如可以是 Binary(每一维代表某个特征有或没有) 或者 One-hot,或者设定一个 codebook( a set of vectors),计算 embedding 与这些向量之间的相似度,然后将其中相似度最大的向量再输入到 decoder 中,这里的 codebook 也是需要从训练数据中学习的。

In general,embedding 从原来的无限种可能变成了有限种可能。

VAE 则是 encoder 将输入数据映射到一个 latent space(通常是多维正态分布),而非直接映射到一个固定的 latent vector,decoder 再从该分布中 sample 来生成数据,这样 VAE 不仅能够重建输入样本,还能够生成新的数据样本。

Auto-encoder 可以应用于 Anomaly Detection(异常检测),比如 Cancer Detection,难点在于负样本通常很少,所以一般的分类很难 work。

Recent Advances

TODO

Generative Approach

Predictive Approach

Contrastive Learning

Bootstrapping Approach

8. Explainable AI (XAI)

模型可解释性库:Captum - Model Interpretability for PyTorch

目前的 DL:

未来的目标:根据解释的结果来修正模型

Explainable:给予黑箱可解释的能力

Interpretable:解释的对象本来就不是黑箱

Goal of XAI

We do not need to completely know how an ML model works. Because we do not completely know how human brains work, but we trust the decisions of humans!

Why we trust the decisions of humans? Usually, You need a reason (or an excuse) to convince people to believe you (The Copy Machine Study by Ellen Langer). So Good XAI make people (your customers, your boss, yourself) acceptable/comfortable/happy.

我们不知道机器到底真正在想什么,我们希望的是通过某些方法解读出来的东西是人看起来会觉得很开心的(然后就可以编故事说机器就是这么想的)。

Local Explanation & Global Explanation

给定一个 classifier,以及其 input (e.g., molecule) 和 output (e.g., non-toxic)。Local Explanation 问的是“为什么这个分子没有毒性”;Global Explanation 问的是“什么样的分子是没有毒性的”,而不是针对某个特定的分子。

Local Explanation: Explain the Decision

-

Which component of input data is critical?

从 gradient 的角度,对于 \(\{x_1, \cdots, x_n, \cdots, x_N\} \longrightarrow \{x_1, \cdots, x_n +\Delta x, \cdots, x_N\}\),有 \(e \longrightarrow \Delta e\),这里的每一个 \(x\) 是一个 component,举例来说,对应 image 而言就是一个 pixel,对于 sequence 而言就是一个 token。\(e\) 就是 loss。如果某个 \(x\) 加上很小的 \(\Delta x\),\(\Delta e\) 却很大,则说明这个 component 是重要的。因此,可以用 \(\vert\frac{\Delta e}{\Delta x}\vert\) 来代表 \(x_n\) 的重要性,实际上就是把 \(x_n\) 对 loss 做偏微分。 把所有的这个比值都算出来后,就可以得到 Saliency Map。

SmoothGrad: Randomly add noises to the input, get saliency maps of the noisy input, and average them. 可以更明显地展示出 saliency map 中对模型决策重要的区域。

只考虑 gradient 会有 gradient saturation 的限制,可以采用 Integrated gradient 来替代。

-

How a network processes the input data?

-

Visualization - 可视化观察网络某个层的输出。

-

Probing - 训练一个探针(其实就是一个分类器)插入到网络的某一层中,将这一层输出的 embeddings 输入到分类器中,通过分类器的输出判断目前的 embeddings 到哪一个阶段了或是否学到了什么。但是要注意分类器是否训练成功,因为如果 accuracy 很低,有可能是机器没有学到,也有可能是机器学到了但是分类器训练得很烂,或者是 accuracy 很高,可能因为机器没有学好但是分类器过拟合导致乐观估计。

-

Global Explanation: Explain the Whole Model

首先 Training a generator with data: input low-dim vector \(z\) into a generator \(G\) (GAN, VAE, etc.) and the generator outputs \(X\) (\(X = G(z)\))。然后将 \(X\) 输入到一个 classifier 中输出 \(y\),希望找到一个 \(z\) 使得 \(y\) 中的某一个 dim / 某一个类别的概率越高越好,即 \(z^* = \arg \max\limits_z y_i\),最后将 \(z^*\) 输入到 \(G\) 中,观察产生的 \(X^*\) 是什么样子,从而可以知道在机器眼中某一个类别是长什么样子的。

还可以尝试用简单的 Linear Model 尽可能地模仿复杂黑盒模型的行为,然后再去分析 Linear Model 也许就可以解释复杂模型。例如 LIME (Local Interpretable Model-Agnostic Explanations) 是用 Linear Model 去模仿复杂模型的一小个区域内的行为,因为 Linear Model 能力有限,很难模仿整个复杂模型的行为。LIME Video1, LIME Video2

9. Adversarial Attack

对于药物设计来说,目前研究的重点更倾向于提高模型的预测准确性和可靠性或解决特定的生物医学问题,而不是对抗潜在的对抗性攻击(安全性)。另外,药物设计领域要构造有效的对抗性样本也比较困难。

10. Domain Adaptation

Domain adaptation can be considered a part of transfer learning.

Domain shift: Training and testing data have different distributons.

Source domain 是 with labeled data 的,随着对 target domain 的了解程度不同,有不同的 domain adaptation 的方法。

-

在 target domain 上有大量数据且有标签:

直接做训练就好了,根本不需要做 domain adaptation。

-

在 target domain 上有少量数据且有标签:

用这些少量数据来对已经在 source domain 上训练好的模型进行微调,需要注意的是,由于数据量很少,所以不要在 target domain 上跑太多的 epoch(maybe 个位数?),避免过拟合。

-

在 target domain 上有大量数据但无标签:

Basic Idea:训练两个 Feature Extractor,分别接收来自 source domain 和 target domain 的输入,然后输出各自的 feature(一个 vector)。Feature Extractor 被训练成能够抽取出两者共同的部分,即各自的 feature 的分布几乎相同。

Domain Adversarial Training

可以将一个 classifier 视为 feature extractor 和 label predictor 两部分,其中哪些部分算 feature extractor,哪些部分算 label predictor 是自行决定的(也算是一个 hyperparameter)。然后再训练一个二元的 domain classifier,它的输入是 feature extractor 所输出的 feature,输出是判断这个 feature 来自于哪个 domain。domain classifier 要做的事是能够正确分类原本来自于哪个 domain,而 feature extractor 则是要模糊界限骗过 domain classifier。所以可以看作是 feature extractor 扮演 generator 的角色,domain classifier 扮演 discriminator 的角色。

以数学公式的角度来看,对于 label predictor,存在参数 \(\boldsymbol{\theta_p}\) 和 loss \(L\),要求得 \(\boldsymbol{\theta_p^*} = \arg \min\limits_{\boldsymbol{\theta_p}}L\);对于 domain classifier,存在参数 \(\boldsymbol{\theta_d}\) 和 loss \(L_d\),要求得 \(\boldsymbol{\theta_d^*} = \arg \min\limits_{\boldsymbol{\theta_d}}L_d\);对于 feature extractor,存在参数 \(\boldsymbol{\theta_f}\),要求得 \(\boldsymbol{\theta_f^*} = \arg \min\limits_{\boldsymbol{\theta_f}}L - L_d\)。

以上是假设两个 domain 内类别集完全相同的情况,但实际上这可能并不总是成立,Universal Domain Adaptation 考虑了 target domain 可能包含 source domain 未见过的新类别,同时也可能缺少 source domain 中的一些类别。目标是使模型能够识别和适应 target domain 中的已知类别(即两者共有的类别),同时对于 target domain 特有的未知类别,模型也能够进行有效的区分和处理。

-

在 target domain 上有少量数据且无标签:

-

对 target domain 一无所知:

Domain Generalization

11. Deep RL

在有标签的数据收集有困难且不知道正确答案的情况下可以考虑 RL。

Machine Learning ≈ Looking for a Function

在 RL 中会有一个 Actor (or Agent) 和一个 Environment,两者会进行互动,Environment 会给 Actor 一个 Observation (or State) 作为其输入,Actor 看到这个 Observation 后会输出一个 Action 去影响 Environment,Environment 改变后就会产生新的 Observation,再进行下一次的互动。所以,Actor 在这里其实就是我们要找的 Function(\(\text{Action} = f(\text{Observation})\))。同时,在互动的过程中,Environment 会不断地给 Actor 一些 Reward 来告诉它现在的 Action 是好的还是不好的。最终 Function 的目标是要最大化所获得的 Reward 的总和。

RL Framework (Also 3 Steps)

-

Function with Unknown

This function is “Actor”, usually called “Policy Network”. The input of policy network is the observation of machine represented as a vector or a matrix. The output is the score for each possible action. The architecture of network is customized. The usual strategy for selecting which action to take is randomly sampling based on the scores as the corresponding probabilities. RL 的结果受 Sample 的影响非常大。

-

Define Loss Function from Training Data

完成一次 Game Over(达到目标状态/完成任务/任务失败)的整个过程,称作是一个 episode,并得到一个 Total Reward(或者称作 Return)\(R = \sum^T_{t=1}r_t\),目标就是要在一个 episode 或多个 episode 中最大化累积的奖励 \(R\) ,也可以说 \(-R\) 就是 loss。

-

Optimization

存在一个互动过程 \(\begin{gather*} env \rightarrow s_0 \rightarrow actor \rightarrow a_0 \rightarrow env \rightarrow s_1 \rightarrow actor \\ \rightarrow a_1 \rightarrow env \rightarrow s_2 \rightarrow actor \rightarrow a_2 \rightarrow \cdots \end{gather*}\),可以用 trajectory(轨迹)来描述,即 \(\tau = (s_0, a_0, s_1, a_1, s_2, a_2, \cdots)\)。同时,在这个互动过程中的每个时间步 \(t\),reward \(r_t\) 的获得都需要依据 \(s_t\) 和 \(a_t\),所以有 \(R(\tau) = \sum^T_{t=1}r_t\)。因此,Optimization 的做法就是调 Network(Actor)的参数使 \(R(\tau)\) 的数值越大越好。

难点在于:1)Actor 的输出是有随机性的,因为 \(a_1\) 是 randomly sample 产生的。给定一个 \(s_1\),每次输出的 \(a_1\) 不一定一样。(用期望值)2)Environment 和 Reward 都是 black box,很难解释它们的输出是为什么。(只需要与环境交互,不需要了解环境的内部机制)3)Environment 和 Reward 往往也是有随机性的。(用期望值)

对于 Actor 来说,有 \(s \longrightarrow \text{Actor}(\text{with param} \ \boldsymbol{\theta}) \longrightarrow a\),如果在特定的 \(s\) 的情况下想要输出特定的 \(a\),可以计算 \(a\) 与 ground truth \(\hat{a}\) 之间的交叉熵 \(e\)。假设有一组训练数据对 \(\{s_1, \hat{a}_1\}, \{s_2, \hat{a}_2\}, \{s_3, \hat{a}_3\}, \cdots, \{s_N, \hat{a}_N\}\),如果期待 Actor 能够执行的行为是 take action \(\hat{a}_1, \hat{a}_3\) 且 don’t take action \(\hat{a}_2\),则 loss 为 \(L = e_1 - e_2 + e_3 \cdots\),然后再去 learn 参数 \(\boldsymbol{\theta}\) 使 loss 最小(\(\boldsymbol{\theta}^* = \arg \min\limits_{\boldsymbol{\theta}}L\))。更进一步,如果每个行为并不是只有好或不好,而是有一个程度可以衡量(不再是一个 binary 的问题),即每一训练数据对 \(\{s_t, \hat{a}_t\}\) 都有相对应的一个分数 \(A_t\) 作为想要执行该行为的程度。因此,loss 也就变为 \(L = \sum A_t e_t\)。

那么现在的问题是应该如何正确地获得训练数据对 \(\{s_t, \hat{a}_t\}\) 和分数 \(A_t\)?

Version 0:首先随机初始化一个 Actor,在与 Environment 的交互中得到训练数据对 \(\{s_t, a_t\}\),然后在多个 episode 中收集到足够的数据。Reward \(r_t\) 就当作 action 的分数 \(A_t\)(\(A_t = r_t\))。但是,由于一个 action 不仅会影响当前的 reward,还会影响后续的 observation,进而影响后续的 reward。所以 Version 0 是一个 short-sighted version。

Reward Delay: Actor has to sacrifice immediate reward (or do something that cannot get any reward) to gain more long-term reward.

Version 1:改进了 Version 0 不合理的点,将以当前点来看未来所有的 reward 加起来来评估当前 action 的好坏,即计算 cumulative reward \(G_t = r_t + r_{t+1} + \cdots + r_N = \sum^N_{n=t}r_n\),令 \(A_t = G_t\)。这样即使当前的 reward 为 0,只看当前的 reward 无法判断 action 的好坏,但是由于 action 还会造成后续的一系列影响,所以也能够知道当前的 action 是好还是坏。

Version 2:由于 \(G_t\) 的公式是加和后续所有的 \(r\),可能有 \(r_t\) 对距离很远的 \(r\) 的贡献很小。所以进一步改进了 \(G_t\) 的公式,设定一个 discount factor \(\gamma < 1\),从而有 Discounted Cumulative Reward \(G_t' = r_t + \gamma r_{t+1} + \gamma^2 r_{t+2} + \cdots + \gamma^{N-t} r_N = \sum^N_{n=t} \gamma^{n-t} r_n\),令 \(A_t = G_t'\)。

Version 3:由于 reward 好还是坏是相对的,所以需要做 Normalization(也能够降低方差)。可以让所有的 \(G_t'\) 都减去一个 baseline \(b\)(\(A_t = G_t' - b\))来实现。

Policy Gradient

-

Initialize actor network parameters \(\boldsymbol{\theta^0}\)

-

For training iteration \(i\) = \(1\) to \(T\):

- Using actor \(\boldsymbol{\theta^{i-1}}\) to interact with the environment

- Obtain data \(\{s_1, a_1\}, \{s_2, a_2\}, \{s_3, a_3\}, \cdots, \{s_N, a_N\}\) (Data collection is in the “for loop” of training iterations)

- Compute \(A_1, A_2, \cdots, A_N\)

- Compute loss \(L\)

- Update parameters \(\boldsymbol{\theta^i} \leftarrow \boldsymbol{\theta^{i-1}} - \eta \nabla L\)

Each time you update the model parameters, you need to collect the whole training set again. One explanation is that the data collected by \(\boldsymbol{\theta^{i-1}}\) is the result of \(\boldsymbol{\theta^{i-1}}\) interacting with the environment, so that is the experience of \(\boldsymbol{\theta^{i-1}}\). This experience can be used to update \(\boldsymbol{\theta^{i-1}}\), however, maybe not be good for \(\boldsymbol{\theta^{i}}\). (The same action results in different rewards for actors with different capabilities)

另一种讲法(衔接 PPO):

在给定 Actor 的参数 \(\theta\) 下,与环境互动得到某一个 trajectory \(\tau\) 的概率为 \(p_{\theta}(\tau) = p(s_1) \prod\limits^T_{t=1} p_{\theta}(a_t \mid s_t) p(s_{t+1} \mid s_t,a_t)\),所以 Reward \(R(\tau) = \sum\limits^T_{t=1} r_t\) 在这里应该是 Expected Reward \(\bar{R_{\theta}} = \sum\limits_{\tau} R(\tau) p_{\theta}(\tau) = E_{\tau \sim p_{\theta}(\tau)}[R(\tau)]\)。因此可以计算出 gradient 为

可以直观理解为如果在某个 \(s_t\) 执行的 \(a_t\) 导致 \(R(\tau)\) 是正的(大于 baseline 更合理),就增加 \(\{s_t, a_t\}\) 这一项的概率;反之,则减少概率。

所以,就可以用 gradient ascent 来做 update(每一次 update 前都需要先收集 \(\tau^n\) 和 \(R(\tau^n)\)),即 \(\theta \leftarrow \theta + \eta \nabla \bar{R_{\theta}}\)。

Cross-Entropy Loss 的公式为:\(L(\theta) = - \frac{1}{N} \sum\limits^N_{i=1} \sum\limits^C_{j=1} y_{ij} \log(p(y=j \mid x_i;\theta))\),其中 \(C\) 指有 \(C\) 个类别,\(y_{ij}\) 是一个指示变量,如果样本 \(i\) 属于类别 \(j\),则其值为 1,否则为 0。对于单个样本 \(x_i\),\(p(y=j \mid x_i;\theta)\) 为模型对每个类别 \(j\) 的预测概率。

Log-Likelihood 的公式为:\(\log L(\theta) = \sum\limits^N_{i=1} \sum\limits^C_{j=1} y_{ij} \log(p(y=j \mid x_i;\theta))\)

因此,对于分类问题,我们在最小化交叉熵损失时,实际上是在最大化对数似然,所以最小化交叉熵等同于最大化似然(交叉熵直接衡量了模型预测概率分布与真实概率分布之间的差异,而最大化对数似然意味着寻找能够使得模型预测概率最接近真实标签概率的模型参数)。

具体操作上,对于 Actor 输出 \(a_t\)(选择采取哪一个动作)可以看作是一个分类问题(输出给定状态下动作的概率分布),由于最小化交叉熵等同于最大化似然,所以最大化 \(\frac{1}{N} \sum\limits^N_{n=1} \sum\limits^{T_n}_{t=1} \log p_{\theta}(a^n_t \mid s^n_t)\) 这个目标函数就可以通过最小化交叉熵损失来实现,而它的梯度 \(\frac{1}{N} \sum\limits^N_{n=1} \sum\limits^{T_n}_{t=1} \nabla \log p_{\theta}(a^n_t \mid s^n_t)\) 在 PyTorch 中可以自动计算。在这个基础上,只需要在损失函数前乘上一个 weight,即 \(R(\tau^n)\)。

另外,考虑 baseline 的话,Expected Reward 的 gradient 就变为 \(\nabla \bar{R_{\theta}} = \frac{1}{N} \sum\limits^N_{n=1} \sum\limits^{T_n}_{t=1} (R(\tau^n) - b) \nabla \log p_{\theta}(a^n_t \mid s^n_t)\),\(b\) 可以取 \(E[R(\tau)]\),\(E[R(\tau)]\) 是会随着 training 不断改变的,即每得到一个 \(R(\tau^n)\),其值就会更新。

对于一个 \(\tau\) 中的所有 action 都赋予相同的权重(\(R(\tau^n)-b\))看似并不合理,一个做法是用 \(\sum\limits^{T_n}_{t=t'} r^n_{t'}\) 替换 \(R(\tau^n) = \sum\limits^{T_n}_{t=1} r^n_t\),防止在这个 action 发生之前的 reward 的影响,认为只有在这个 action 发生之后的所有 reward 是与它有关的。更进一步,加一个 discount factor \(\gamma < 1\) 减小离 \(t'\) 较远的 reward 的影响(action 对远端的 reward 的贡献会逐渐减小),即 \(\sum\limits^{T_n}_{t=t'} r^n_{t'}\) 变为 \(\sum\limits^{T_n}_{t=t'} \gamma^{t-t'} r^n_{t'}\)。因此,可以说 total reward 是 state-dependent。\((\sum\limits^{T_n}_{t=t'} \gamma^{t-t'} r^n_{t'} - b)\) 这一项也被称为 Advantage Function,用 \(A^{\theta}(s_t,a_t)\) 来表示。

Mentioned above is “On-policy”, i.e., the actor to train and the actor to interact is the same.

“Off-policy” is that the two can be different. In this way, we do not have to collect data after each update, it enables the use of previously collected data. But the actor to train has to know its difference from the actor to interact. The most commonly used technique is Proximal Policy Optimization (PPO).

Exploration:Actor 在收集数据时的随机性需要大一点,才能收集到更丰富的数据(尝试更多的 Action),因为如果有些 Action 从来没有被执行过,那根本就无法知道这个 Action 好或不好。可能的做法是:1)增大 Actor 输出的策略分布的 entropy(即概率分布更均匀),从而增大随机性(降低预测性);2)在 Actor 的参数上加 noise。

PPO

Importance Sampling

For \(E_{x \sim p}[f(x)] \approx \frac{1}{N} \sum^N_{i=1} f(x^i)\), \(x^i\) is sampled from distribution \(p(x)\). But if we only have \(x^i\) sampled from distribution \(q(x)\), the formula is modified to \(E_{x \sim p}[f(x)] = \int f(x)p(x)dx = \int f(x)\frac{p(x)}{q(x)}q(x)dx = E_{x \sim q}[f(x)\frac{p(x)}{q(x)}]\),可以理解为因为变成了从 \(q(x)\) 中 sample data,所以对 sample 出来的每一笔 data 都需要乘上一个 weight \(\frac{p(x)}{q(x)}\) 来修正这两个分布之间的差异。实作上,这两个分布之间的差异不宜过大,如果它们之间差异过大,会导致它们的 variance 差很多,此时 sample 的次数不够多就会导致它们的 expectation 相同无法成立。公式说明:由 \(Var[X] = E[X^2] - (E[X])^2\),有 \(Var_{x \sim p}[f(x)] = E_{x \sim p}[f(x)^2] - (E_{x \sim p}[f(x)])^2\) 和 \(Var_{x \sim q}[f(x)\frac{p(x)}{q(x)}] = E_{x \sim q}[(f(x)\frac{p(x)}{q(x)})^2] - (E_{x \sim q}[f(x)\frac{p(x)}{q(x)}])^2 = E_{x \sim p}[f(x)^2\frac{p(x)}{q(x)}] - (E_{x \sim p}[f(x)])^2\),差距就在于第一项多乘了一项 \(\frac{p(x)}{q(x)}\)。

利用 Importance Sampling 从 On-policy 到 Off-policy,使用另外一个 actor with policy \(\pi_{\theta'}\) 与环境做互动来 sample \(\tau\) 然后用于训练 \(\theta\),Expected Reward 的 gradient 就变为 \(\nabla \bar{R_{\theta}} = E_{\tau \sim p_{\theta'}(\tau)}[\frac{p_{\theta}(\tau)}{p_{\theta'}(\tau)} R(\tau) \nabla \log p_{\theta}(\tau)]\),这样做可以多次利用采样得到的数据,而不是像 on-policy 一旦 \(\theta\) 更新 \(\pi_{\theta}\) 就必须重新再采样新的数据。因此,可知 objective function 为 \(J^{\theta'}(\theta) = E_{(s_t,a_t) \sim \pi_{\theta'}}[\frac{p_{\theta}(a_t \mid s_t)}{p_{\theta'}(a_t \mid s_t)}A^{\theta'}(s_t,a_t)] \approx \sum\limits_{(s_t,a_t)} \frac{p_{\theta}(a_t \mid s_t)}{p_{\theta'}(a_t \mid s_t)}A^{\theta'}(s_t,a_t)\)。

PPO 在此基础上再加一个限制使得两个分布不能差太多。PPO-Penalty 的 objective function 为 \(J^{\theta'}_{PPO}(\theta) = J^{\theta'}(\theta) - \beta KL(\theta, \theta')\),希望的是在训练中学出来的 \(\theta\) 和 \(\theta'\) 越像越好(最大化 objective function 需要 KL 散度尽可能小)。这里的 KL 散度指的是这两个参数所对应的 policy 输入同一个 state 输出的 action 的 distribution 之间的距离。\(\beta\) 是一个 adaptive 的惩罚项,如果 \(KL(\theta, \theta') > KL_{max}\),增大 \(\beta\),如果 \(KL(\theta, \theta') < KL_{min}\),减小 \(\beta\)。

还有一种 variant 是 PPO-Clip(the primary variant used at OpenAI),它的 objective function 为 \(J^{\theta'}_{PPO2}(\theta) \approx \sum\limits_{(s_t,a_t)} \min(\frac{p_{\theta}(a_t \mid s_t)}{p_{\theta'}(a_t \mid s_t)}A^{\theta'}(s_t,a_t), \text{clip} (\frac{p_{\theta}(a_t \mid s_t)}{p_{\theta'}(a_t \mid s_t)}, 1-\epsilon, 1+\epsilon)A^{\theta'}(s_t,a_t))\)。clip 函数的意思是如果第一项小于第二项就输出第二项,如果第一项大于第三项就输出第三项。具体的实现是用其简化版 \(J^{\theta'}_{PPO2}(\theta) = \sum\limits_{(s_t,a_t)} \min (\frac{p_{\theta}(a_t \mid s_t)}{p_{\theta'}(a_t \mid s_t)}A^{\theta'}(s_t,a_t), \ g(\epsilon, A^{\theta'}(s_t,a_t)))\),其中 \(g(\epsilon, A) = \begin{cases} (1+\epsilon)A & A \ge 0 \\ (1-\epsilon)A & A < 0 \end{cases}\)。如果 \(A\) 为正,则说明这个 action 是好的,我们会希望这个 action 被采取的概率 \(p_{\theta}(a_t \mid s_t)\) 越大越好,但是不能超过 \((1+\epsilon)p_{\theta'}(a_t \mid s_t)\),即 \(J^{\theta'}_{PPO2}(\theta) = \sum\limits_{(s_t,a_t)} \min (\frac{p_{\theta}(a_t \mid s_t)}{p_{\theta'}(a_t \mid s_t)}, (1+\epsilon)) A^{\theta'}(s_t,a_t)\);同样地,如果 \(A\) 为负,我们会希望 \(p_{\theta}(a_t \mid s_t)\) 越小越好,但是不能小于 \((1-\epsilon)p_{\theta'}(a_t \mid s_t)\),即 \(J^{\theta'}_{PPO2}(\theta) = \sum\limits_{(s_t,a_t)} \max (\frac{p_{\theta}(a_t \mid s_t)}{p_{\theta'}(a_t \mid s_t)}, (1-\epsilon)) A^{\theta'}(s_t,a_t)\),从而保证两个分布差距不会太大。

额外链接:https://spinningup.openai.com/en/latest/algorithms/ppo.html

Actor-Critic

Critic: Given actor \(\boldsymbol{\theta}\), how good it is when observing \(s\) (and taking action \(a\))

Value Function (or State-Value Function) \(V^{\boldsymbol{\theta}}(s)\): (is a critic) When using actor \(\boldsymbol{\theta}\), the discounted cumulative reward expects to be obtained after seeing observation \(s\).(未卜先知,提前预测 discounted cumulative reward)

How to estimate \(V^{\boldsymbol{\theta}}(s)\)?

-

Monte-Carlo (MC) Based Approach: The critic watches actor \(\boldsymbol{\theta}\) to interact with the environment, it will obtain a set of training data \(\{s_1, G_1'\}, \{s_2, G_2'\}, \{s_3, G_3'\}, \cdots\) for value function \(V^{\boldsymbol{\theta}}\) at the end of the episode. \(V^{\boldsymbol{\theta}}\) will be input with \(s_t\) and output \(V^{\boldsymbol{\theta}}(s_t)\), \(V^{\boldsymbol{\theta}}(s_t)\) should be as close as possible to \(G_t'\).

-

Temporal-difference (TD) Approach: There’s no need to complete the whole episode (or the episode may not be able to be completed in some cases.), just \(s_t, a_t, r_t, s_{t+1}\) is enough to update the parameters of \(V^{\boldsymbol{\theta}}\) in each episode. The goal is that \(V^{\boldsymbol{\theta}}(s)\) is as close as possible to \(G'\), so there are following relationships

Therefore, the problem is transformed into \(V^{\boldsymbol{\theta}}(s_t) - \gamma V^{\boldsymbol{\theta}}(s_{t+1})\) should be as close as possible to \(r_t\).

Version 3.5:baseline \(b\) 的一个可能的选择是 \(V^{\boldsymbol{\theta}}(s_t)\),即 \(A_t = G_t' - V^{\boldsymbol{\theta}}(s_t)\)。实际上,由于当 actor 看到 \(s_t\) 时所采取的 action 是根据概率分布随机采样的,所以会得到多种可能的 \(G'\),而这些 \(G'\) 的平均值(期望值)就是 \(V^{\boldsymbol{\theta}}(s_t)\) 的含义,也就是相当于平均水平。当采取特定 action \(a_t\) 时,会得到相对应的 \(G_t'\)。如果 \(A_t\) 为正,意味着动作 \(a_t\) 比平均情况更有利,反之亦然。

Version 4:Version 3.5 中计算 \(A_t\) 时只用了在 state \(s_t\) 下某个特定 action 的 \(G_t'\),忽略了其他的可能,而 \(V^{\boldsymbol{\theta}}(s_t)\) 则是考虑了所有的可能。当 \(s_t\) 进行到 \(s_{t+1}\) 后,可以把 \(V^{\boldsymbol{\theta}}(s_{t+1})\) 作为在 state \(s_{t+1}\) 下所有可能的 \(G'\) 的平均值(期望值),再加上 \(s_t\) 的 reward \(r_t\) 后,即 \(r_t + V^{\boldsymbol{\theta}}(s_{t+1})\) 就可以代表在 state \(s_t\) 下考虑到了所有的可能后的 \(G_t'\)。最后考虑到折扣因子 \(\gamma\),最终的公式为 \(A_t(s_t, a_t) = r_t + \gamma V^{\boldsymbol{\theta}}(s_{t+1}) - V^{\boldsymbol{\theta}}(s_t)\)。该公式也被称为 Advantage Function,可以用于衡量在给定 state 下,采取特定 action 相比于平均情况下能带来多少额外收益,从而帮助 actor 做出更好的 action。这样当 Advantage Function 作为 Critic 时被称为 Advantage Actor-Critic (A2C)。Tip:由于 Actor 和 Critic 的输入是同一个 \(s\),所以它们可以共享网络前面几层的参数。

基础的 Actor-Critic 是用 Action-Value Function 来作为 Critic,即 \(A^{\pi}(s, a) = Q^{\pi}(s, a) - V^{\pi}(s)\),其中 \(Q^{\pi}(s, a)\) 就是 Action-Value Function。简单地说,\(Q^{\pi}(s, a)\) 表示在状态 \(s\) 下采取动作 \(a\) 并遵循特定策略 \(\pi\) 的期望回报,\(V^{\pi}(s)\) 表示在状态 \(s\) 下遵循特定策略 \(\pi\) 的期望回报。策略 \(\pi\) 就是 Policy Network/Agent with parameter \(\boldsymbol{\theta}\)。

P.S. Deep Q Network (DQN) 只用 Critic 就可以决定选择哪个 action。

Reward Shaping

If reward is sparse, i.e., \(r_t = 0\) in most cases, we don’t know actions are good or bad. 这时可以采用 reward shaping 的方法,定义 extra reward(正或负)来指导 agent,但是不同的 action 的 extra reward 的值具体应该设为多少需要依据 domain knowledge 来保证设置的正确。

Curiosity-based reward shaping: Obtaining extra reward when the agent sees something new (but meaningful). agent 被激励去探索更多未知的环境,学习更多 state 和 action 的组合(\(\{s, a\}\)),从而加速学习过程。

适用情况:例如下围棋是只有结尾才能判断输或赢,即只有 \(r_N\) 才有分数,分子生成也可以是这样,只有生成完整个分子才能判断是好还是坏。(用最原始的方法也可以做,那就是如果 \(r_N\) 是好的,那之前一连串的 Action 都算是好的,反之亦然。)

No Reward

In some cases, define reward is challenging and hand-crafted rewards (reward shaping) can lead to uncontrolled behavior.

Imitation Learning

Actor can interact with the environment, but reward function is not available. 取而代之的是,用专家示范(demonstration of the expert)来引导 Agent 的学习过程。专家示范通常是一系列 trajectory \(\{\hat{\tau}_1, \hat{\tau}_2, \cdots, \hat{\tau}_K \}\),每个 trajectory 就是一系列状态 \(s\) 和在这些状态下采取的动作 \(a\) 对 \(\{s_1, \hat{a}_1, s_2, \hat{a}_2, \cdots \}\)。Agent 的学习过程可以通过 Supervised Learning 来实现,即尝试学习一个函数,可以映射状态到动作,以最小化其行为 \(a_t\) 与专家行为 \(\hat{a}_t\) 之间的差异,这样的做法叫做 Behavior Cloning。

但是这样做的问题是专家示范中可能只包含了有限的情况,有更多罕见的情况如果 Agent 没有学过它就可能会不知道如何处理,从而能力会受到限制。另一个问题是。Agent 会复制专家的每一个行为,甚至是和目标不相关的行为,甚至如果 Agent 学到的只是专家的一部分行为,而不是全部,有可能学到的这些行为反而是那些没用的,会导致其能力大打折扣。

Inverse Reinforcement Learning (IRL)

既然人定的 reward 会有问题,那就让机器自己去定。

IRL 的做法是从专家示范和 Environment 中学出 Reward Function。然后再将其用到 RL 中去学出 Actor。学出来的 Reward Function 可能很简单,但不代表由它学出来的 Actor 也是简单的。

IRL 遵循的原则是:The expert is always the best。

基本的步骤是:

- Initialize an actor \(\pi\)

-

In each iteration

-

The actor interacts with the environments to obtain some trajectories \(\{\tau_1, \tau_2, \cdots, \tau_K \}\)

-

Define a reward function \(R\), which assigns higher reward to the trajectories of the expert than to those of the actor \(\sum^K_{n=1}R(\hat{\tau}_n) > \sum^K_{n=1}R(\tau)\)

-

The actor learns to maximize the reward based on the new reward function by RL

-

- Output the reward function and the actor learned from the reward function

IRL 和 GAN 有异曲同工之妙,IRL 的 Actor 就是 GAN 的 Generator,Reward Function 就是 Discriminator。

12. Lifelong Learning

也可以叫做 Continual Learning。

Catastrophic Forgetting:机器学习了新的任务后就忘记了如何解决旧的任务,但机器是有足够的能力同时很好地解决新和旧的任务。

一个可行的解决方案是 Multi-Task Learning(把多个任务的有标记的训练数据合并当作一个任务进行训练),但是如果任务数过多,再学习新的任务则需要把之前学过的所有任务再看一遍,效率低且可能会导致 Storage issue 和 Computation issue。(相当于每次学习新知识前都要先复习,效果肯定好但是效率会低)

Multi-Task Learning can be considered as the upper bound of Lifelong Learning.

为什么不一个任务训练一个模型呢?我们希望最终的模型是可以胜任多种不同的任务,既然人脑可以,那为什么机器不行呢?而且一个任务训练一个模型就没办法从其他任务中学到从单一任务中无法学到的信息。和 Transfer Learning 相比,两者的关注点不同。Transfer Learning 关注的是机器在旧的任务上学到的知识能不能对新的任务有所帮助,我们在乎的是机器能否胜任新的任务;Lifelong Learning 关注的则是当机器学完新的任务后是否忘记了旧的任务,我们在乎的是机器还能否胜任旧的任务。

Evaluation

First of all, we need a bunch of tasks.

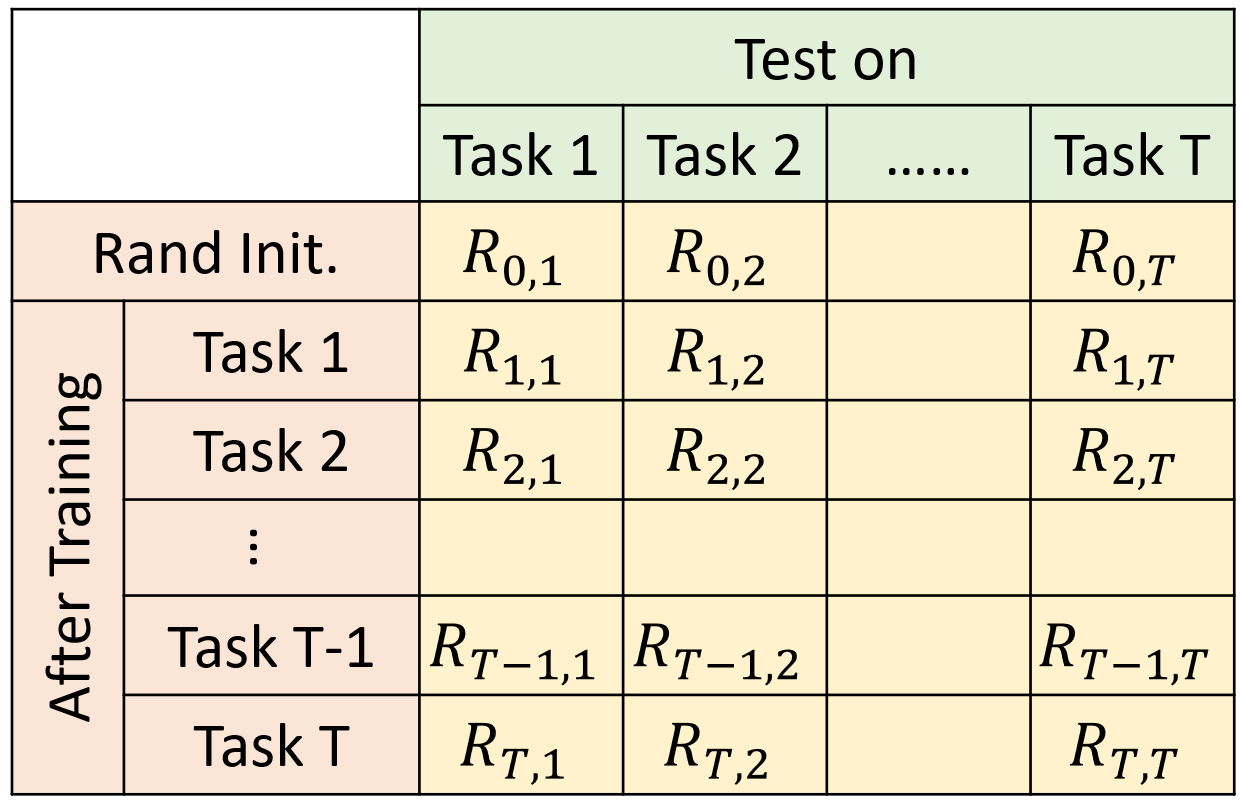

\(R_{i, j}\): after training task \(i\), performance on task \(j\).

If \(i > j\): after training task \(i\), does task \(j\) be forgot.

If \(i < j\): task \(j\) has not been learned yet, can we transfer the skill of task \(i\) to task \(j\).

Evaluation method:

- \(\text{Accuracy} = \frac{1}{T}\sum^T_{i=1}R_{T,i}\),即在机器学完所有任务后,评估其在之前任务上的表现。